Mit Milliarden von Nutzern weltweit stehen Social-Media-Plattformen vor gewaltigen Herausforderungen, wenn es darum geht, sicherzustellen, dass ihre Inhalte den Standards der Community, den gesetzlichen Anforderungen und ethnischen Aspekten entsprechen. Die Moderation von Inhalten umfasst den Prozess des Prüfens, Filterns und eventuellen Einschränkens oder Entfernens schädlicher oder unangemessener Materialien, um für eine sichere und respektvolle Online-Umgebung zu sorgen.

In Anbetracht der erheblichen Reichweite und des Einflusses der Plattformen können die Inhaltsentscheidungen erhebliche soziale, ethische und rechtliche Folgen haben. Dieser Blogbeitrag soll einen Leitfaden zur Moderation von Inhalten bieten. Wir werfen einen Blick auf die zugrundeliegende Motivation der Inhaltsrichtlinien, die beteiligten Prozesse sowie die komplexe Balance zwischen dem Fördern freier Meinung und dem Bewahren von Sicherheitsstandards. Indem wir uns mit dem „Warum“ und dem „Wie“ von Inhaltsmoderation beschäftigen, beleuchten wir die Verfahren und Herausforderungen dieses wichtigen Bereichs der digitalen Verwaltung.

Was ist in sozialen Medien generell verboten?

Social-Media-Plattformen verbieten üblicherweise Inhalte, die gegen ihre Community-Richtlinien, gegen rechtliche Vorschriften oder gegen beides verstoßen. Hier einige Kategorien üblicherweise verbotener Inhalte:

1. Hassrede und Belästigung: Inhalte, die Diskriminierung, Hass oder Gewalt gegen Personen oder Gruppen basierend auf Merkmalen wie Ethnie, Religion, Geschlecht oder sexueller Orientierung fördern.

2. Gewalt und Drohungen: Posts, die zu Gewalt aufrufen, diese androhen oder verherrlichen, einschließlich Gewaltandrohungen gegen Personen, Gemeinschaften oder Gruppen.

3. Jugendgefährdende Inhalte and sexuelle Ausbeutung: Auch wenn auf manchen Plattformen gewisse Formen von Erwachseneninhalten erlaubt sind, ist auf den meisten von ihnen explizit sexuelles Material verboten. Sämtliche Plattformen verbieten die sexuelle Ausbeutung von Minderjährigen und Bilder von nicht einvernehmlicher Intimität.

4. Fehl- und Desinformation: Falsche Informationen, die zu Schäden führen können – etwa gesundheitsbezogene Fehlinformationen oder Desinformationskampagnen vor einer Wahl – können eingeschränkt oder gemeldet werden.

5. Terrorismus und gewaltsamer Extremismus: Inhalte, die Terrororganisationen oder gewaltsamen Extremismus bewerben, oder Inhalte, die Terrorismus verherrlichen oder Personen für Gewalttaten anwerben sollen.

6. Inhalte zu Selbstverletzung und Suizid: Material, das Selbstverletzung, Suizid oder Essstörungen befördert oder verherrlicht, wird häufig entfernt oder gemeldet, wobei auch Hilfestellen angegeben werden.

7. Illegale Aktivitäten: Posts, die illegale Aktivitäten wie Drogen- oder Menschenschmuggel oder den Verkauf verbotener Substanzen oder Waffen betreffen.

8. Schädliche oder täuschende Inhalte: Dies umfasst Scams, Betrug, Phishing oder andere Inhalte, die zum Ziel haben, Nutzer zu täuschen oder auszunutzen, etwa falsche Geschenke oder die Imitation von Personen.

Zu den weiteren Bereichen, zu denen Plattformen häufig Richtlinien erlassen, gehört die Verletzung geistigen Eigentums. Urheber- oder markenrechtlich geschützte Inhalte wie raubkopierte Filme, Musik oder die unerlaubte Vervielfältigung von Kunstwerken ist üblicherweise untersagt, um Verstößen zuvorzukommen. Die Plattformen verfügen zudem oft über Richtlinien zu Spam und irreführenden Inhalten. Dies umfasst Spam-Inhalte, irreführende Links oder Clickbaits, die die Nutzererfahrung beeinträchtigen oder Nutzer auf potenziell schädliche Seiten leiten.

Jede Plattform verfügt über ihre eigenen Richtlinien und Umsetzungspraktiken, die sich in Reaktion auf Verordnungen, gesellschaftliche Bedenken und sich entwickelndes Online-Verhalten ändern können.

Plattformen entfernen häufig Inhalte, um Nutzer vor schädlichen Materialien wie den oben aufgeführten zu schützen. Das Entfernen von Inhalten kann Plattformen helfen, die legale Haftung für das Hosten ungesetzlicher Materialien zu vermeiden, etwa bei Urheberrechtsverletzungen oder Materialien, die Gewalt fördern. Durch das Moderieren von Inhalten können die Plattformen ein Gleichgewicht zwischen der freien Meinungsäußerung und ihrer Verantwortung zum Schutze der Nutzer erzielen und dabei einen positiven Raum für Nutzerengagement und -erfahrung schaffen.

Die Beschreibung der Regeln von Facebook, TikTok und YouTube in diesem Blogpost – und wie diese angewendet werden – wurde vom Appeals Centre Europe basierend auf den Richtlinien der Plattformen mit Stand vom November 2024 entwickelt.

Bitte beachten Sie, dass dieser Artikel nur Informationszwecken dient und keine rechtliche oder professionelle Beratung darstellt. Eine aktuelle Version der Richtlinien der Plattformen finden Sie unter den folgenden Links:

Wofür wir da sind

Das Appeals Centre Europe wurde ins Leben gerufen, um Nutzer dabei zu unterstützen, Inhaltsentscheidungen der Social-Media-Plattformen zu verstehen und anzufechten und so für mehr Transparenz, Gerechtigkeit und Kontrolle auf ihren Lieblingsplattformen zu sorgen.

Wenn Sie mit einer Inhaltsentscheidung von Facebook, TikTok oder YouTube nicht einverstanden sind, können Sie diese über unser Portal anfechten.

Entfernung von Facebook-Inhalten: Was das bedeutet und wie wir damit umgehen

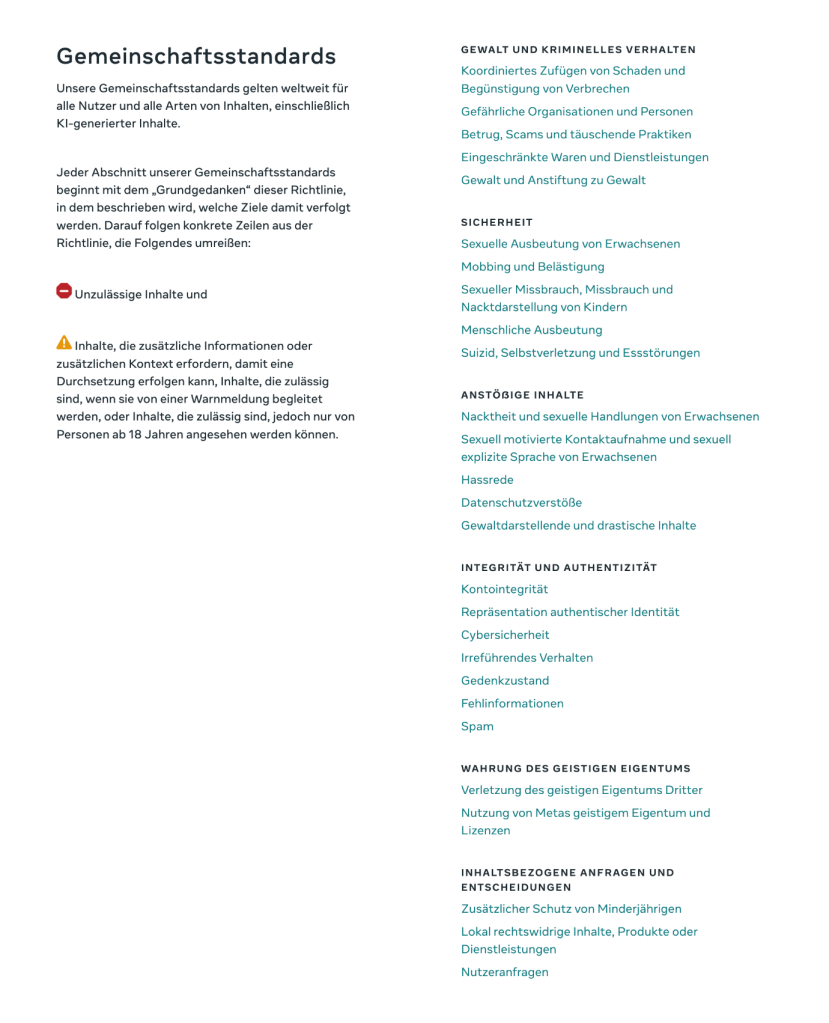

Seit dem 12. November 2024 hat Meta die Community-Standards, die für die Prüfung von Inhalten auf ihren Plattformen, einschließlich Facebook und Instagram, angelegt werden, vereinheitlicht.

Das Verfahren, nach dem Meta Inhalte entfernt, ist komplex, und es kann manchmal der Eindruck entstehen, dass die Regeln nicht eindeutig sind. Unten finden Sie einige Gründe dafür, warum Inhalte entfernt werden können.

Warum Facebook Inhalte entfernt

Facebook entfernt oder beschränkt Inhalte, von denen angenommen werden kann, dass sie gegen die Regeln zu folgenden Punkten verstoßen:

• Gewalt und kriminelles Verhalten

• Sicherheit

• Anstößige Inhalte

• Integrität und Authentizität

• Respektieren geistigen Eigentums

• Inhaltsbezogene Anfragen und Entscheidungen, die Minderjährige, lokale Vorschriften und Nutzeranfragen beinhalten

Eine vollständige Liste der Richtlinien finden Sie hier

Wie meldet Facebook Inhalte?

Facebook nutzt eine Mischung aus KI (künstliche Intelligenz) und geschulten menschlichen Moderatoren, um Posts zu durchsuchen und zu prüfen. So funktioniert es:

• KI-Erkennung: Automatisierte Systeme sind die erste Sicherheitsbarriere. Sie scannen Inhalte nach potenziellen Verstößen und melden Posts aufgrund von Sprache oder Bildern.

• Menschliche Moderation: Wenn sich die KI nicht sicher ist, schreiten menschliche Moderatoren ein, um die Situation genauer zu prüfen und eine finale Entscheidung zu treffen.

Wie Sie gegen eine Entfernung von Inhalten durch Facebook vorgehen

Das Anfechten einer Entscheidung ist einfacher als sie denken! Wenn Sie der Ansicht sind, dass Facebook eine falsche Entscheidung getroffen hat, können Sie Folgendes tun:

1. Prüfen Sie Ihre Nachrichten: Sie erhalten eine Nachricht, wenn Inhalte entfernt werden. Darin ist normalerweise eine Einspruchsoption enthalten.

2. Anfechten von Entscheidungen Facebooks: Ihre Einsprüche werden im Support-Postfach von Facebook nachverfolgt und Sie erhalten Status-Updates. Befolgen Sie diese Schritte, um gegen Entscheidungen von Facebook über deren internen Beschwerdemechanismus vorzugehen.

3. Wenn Sie nach dem Ergreifen dieser Maßnahmen noch immer eine negative Antwort bezüglich der Entscheidung der Inhaltsmoderation erhalten, können Sie sich an das Appeals Centre Europe wenden. Sie benötigen Ihre Facebook-Referenznummer und einige weitere Informationen, die Sie über unsere Website einreichen können, um einen Streitfall einzuleiten.

Wie Sie gegen eine Entscheidung zur Entfernung von Inhalten durch Facebook vorgehen

Wenn Sie sich innerhalb der EU befinden, können Sie Ihren Streitfall über unser Portal einreichen. Auch wenn wir Entscheidungen zu Inhalten in allen in der EU gesprochenen Sprachen akzeptieren, müssen Sie Ihren Streitfall in englischer, deutscher, französischer, niederländischer, italienischer oder spanischer Sprache einreichen. Wenn Sie mehr über das Appeals Centre Europe erfahren möchten, besuchen Sie gerne unsere Homepage.

Wenn Sie Ihre Referenznummer nicht finden können, prüfen Sie bitte diesen Leitfaden.

Einen Streitfall einreichen – So finden Sie Ihre Facebook-Referenznummer

Wenn Ihr Post, Bild, Video oder Kommentar von Facebook entfernt wurde oder Sie Inhalte entdecken, von denen Sie glauben, dass sie entfernt werden sollten, müssen Sie uns eine Facebook-Referenznummer nennen, um den Beschwerdeprozess einzuleiten.

Mithilfe dieser Nummer können wir von Facebook Informationen zu der Entscheidung anfordern. Ohne die Nummer können wir Ihre Beschwerde nicht prüfen.

Um Sie bei der Navigation durch diesen Prozess zu unterstützen, haben wir diesen Schritt-für-Schritt-Leitfaden erstellt.

Was ist die Facebook-Referenznummer und wo kann ich sie finden?

Wenn Facebook Ihren Inhalt entfernt oder Sie Inhalte einer anderen Person melden, erhalten Sie eine Mitteilung mit der Erklärung dieser Entscheidung.

Wenn Sie sich in der EU befinden, sollte diese Mitteilung Informationen über Streitbeilegungsstellen und Ihre einzigartige Facebook-Referenznummer enthalten.

Sie finden diese Nachricht üblicherweise an einem der folgenden Orte:

• Profilstatus: Loggen Sie sich bei Facebook ein und prüfen Sie die Nachrichten in Ihrem Konto.

• Homepage des Business-Supports (für Geschäftskonten): Melden Sie sich bei Ihrem Business-Portal an, um die entsprechenden Nachrichten einzusehen.

Was, wenn ich meine Facebook-Referenznummer nicht finden kann?

Keine Sorge, Sie können sie auch auf andere Weise erhalten. Sie können eine Facebook-Referenznummer auch direkt von Meta über die folgenden Schritte anfordern:

1. Klicken Sie auf diesen Link zum Anfordern einer Meta-Referenznummer.

2. Loggen Sie sich in Ihr Facebook-Konto ein.

3. Füllen Sie die erforderlichen Felder im Formular aus.

Wenn Sie das Formular ausgefüllt haben, wird Ihnen Meta die erforderliche Referenznummer bereitstellen.

Wie reiche ich meine Facebook-Referenznummer ein?

Sobald Sie Ihre Referenznummer erhalten haben, rufen Sie das Fallportal auf, um Ihren Streitfall einzuleiten. Unter Schritt 2: Plattformangaben, wählen Sie „Facebook“ aus dem Dropdown-Menü aus. Es erscheint ein Feld, in das Sie Ihre Facebook-Referenznummer eingeben können.

Dieser Schritt ist entscheidend, damit wir mit Ihrem Streitfall fortfahren können.

Wo finde ich weitere Hilfe?

Wenn Sie während des Vorgangs weitere Unterstützung benötigen:

• Rufen Sie den detaillierten Leitfaden von Meta zu Facebook-Referenznummern auf.

• Abonnieren Sie unsere Facebook-Seite für weitere Tipps, Anleitungen und Updates zu digitalen Rechten und der Inhaltsmoderation. Es kann sehr umständlich wirken, den ersten Schritt in einem Streitfall zu gehen, aber mit den passenden Tools und entsprechender Hilfe können Sie Ihren Fall zügig beilegen.

Wie TikTok Videos entfernt (und wie Sie Einspruch einlegen)

TikToks Moderationsprozesse können manchmal zur unerwarteten Löschung von Videos führen. Wenn Ihr Video entfernt wurde und Sie nicht wissen, warum, sind Sie nicht allein! Sehen wir uns einmal an, warum TikTok Videos entfernt, wie Sie Einspruch einlegen und was zu beachten ist, damit Ihre Inhalte online bleiben.

Warum TikTok Videos entfernt

TikTok befolgt einen detaillierten Satz an Community-Richtlinien, deren Hauptgründe für das Löschen von Videos folgendes umfassen:

• Hassrede und Belästigung: Inhalte, die auf bestimmte Gruppen oder Personen abzielen, können entfernt werden.

• Gewalttätige oder brutale Inhalte: TikTok erlaubt keine gewalttätigen oder brutalen Materialien, selbst wenn diese als Nachrichtenmeldungen gedacht sind.

• Fehlinformationen: TikTok entfernt Inhalte, die irreführend sein können.

Wie TikTok Inhalte moderiert

So überprüft TikTok Posts:

• KI-Erkennung: Automatisierte Systeme melden Inhalte basierend auf bestimmten Schlagwörtern oder Mustern.

• Menschliche Moderatoren: Wenn ein gemeldetes Video nicht eindeutig ist, schreiten Moderatoren für eine finale Prüfung ein.

Wie Sie gegen die Entfernung von Videos durch TikTok vorgehen

Wenn Sie der Ansicht sind, dass Ihr Video nicht hätte entfernt werden dürfen, können Sie in der App dagegen vorgehen:

1. Prüfen Sie Ihre Nachrichten: TikTok wird Sie über die Gründe für die Entfernung Ihres Videos benachrichtigen.

2. Reichen Sie einen Widerspruch ein: In der Nachricht wird Ihnen die Möglichkeit gegeben, zu widersprechen und mehr Kontext zu liefern.

3. Verfolgen Sie Ihren Widerspruch: Sie können den Status Ihres Widerspruchs in der App kontrollieren.

Vermeiden künftiger Löschungen auf TikTok

Um künftige Löschungen zu vermeiden, nutzen Sie keine Sprache oder Bilder, die eine KI-Prüfung auslösen könnten, insbesondere bei sensiblen Themen. Wenn Sie diese Ratschläge beherzigen, bleiben Ihre Inhalte aktiv und Sie können ein angenehmeres Nutzererlebnis bei TikTok genießen.

Weitere Infos

Wir möchten Ihnen die Community-Richtlinien von TikTok empfehlen, in denen die Inhaltsmoderation der Plattform erklärt wird.

Entfernung von YouTube-Inhalten: Warum das passiert und was Sie dagegen tun können

Wenn Sie Creator auf YouTube sind, kann das Entfernen eines Videos erhebliche Auswirkungen haben – insbesondere, wenn Sie die Gründe dafür nicht kennen.

Warum YouTube Videos löscht

YouTube verfügt über Community-Richtlinien, die die Plattform sicher und aktiv halten sollen. Hier einige Gründe dafür, warum Videos entfernt werden können:

• Schädliche Inhalte: Videos, die gefährliche Aktivitäten fördern oder anderen schaden, werden üblicherweise gemeldet.

• Gewalttätige oder brutale Inhalte: Ausdrückliche gewalttätige oder brutale Inhalte sind auf YouTube nicht zugelassen.

• Spam und Fehlinformationen: Inhalte, die irreführende Informationen verbreiten, insbesondere zu Themen wie Gesundheit, können entfernt werden.

Wie entscheidet YouTube, was gelöscht wird und was auf der Plattform verbleiben darf?

YouTube verwendet dazu zwei Ansätze:

• Automatisierte Erkennung: Eine KI prüft die Inhalte auf Warnsignale, wie gefährliche Stunts oder verbotene Bilder.

• Meldung durch Nutzer: Nutzer können Videos melden, und wenn ausreichend Personen das gleiche Video gemeldet haben, kann es von einem Moderator geprüft werden.

So legen Sie Einspruch ein, wenn YouTube Ihr Video gelöscht hat

Wenn Sie der Ansicht sind, dass Ihr Video nicht hätte entfernt werden dürfen, können Sie dieser Entscheidung widersprechen. Hier eine kurze Anleitung:

1. Prüfen Sie Ihre E-Mails: YouTube sendet Ihnen üblicherweise eine E-Mail, in der erklärt wird, warum das Video entfernt wurde.

2. Reichen Sie einen Streitfall ein: Rufen Sie YouTube Studio auf, suchen Sie Ihr Video und erklären Sie, warum Sie der Ansicht sind, dass es nicht gegen die Regeln verstößt.

3. Kontaktieren Sie den Support (falls erforderlich): In komplizierteren Fällen können Sie sich auch direkt an den YouTube-Support wenden.

Tipps, damit Ihre Videos sicher bleiben

Um zu vermeiden, dass Ihre Inhalte entfernt werden, sollten Sie regelmäßig die Richtlinien von YouTube überprüfen – insbesondere, wenn Sie sensible Themen behandeln. So bleiben Ihre Inhalte online und Sie können unerwartete Probleme vermeiden.

YouTube – Community-Richtlinien

Wo verläuft die Grenze zwischen Moderation und Zensur?

Mit der Weiterentwicklung der sozialen Medien geht auch die Diskussion um Zensur weiter. Während Plattformen wie Facebook, TikTok und YouTube angeben, dass sie ihre Inhalte moderieren, um für ein sichereres Umfeld und eine positive Nutzererfahrung zu sorgen, fühlen sich manche Nutzer durch Zensur eingeschränkt.

Die Inhaltsmoderation in den sozialen Medien kann manchmal wie unberechtigte oder unerklärte Zensur oder Löschung wirken. Sehen wir uns deswegen einmal an, wie die Inhaltsmoderation funktioniert, einschließlich einiger Beispiele, und erklären, was Sie tun können, wenn Sie davon betroffen sind.

Warum gibt es Inhaltsmoderation in den sozialen Medien?

Wenn Sie der Ansicht sind, dass Sie in den sozialen Medien zu Unrecht zensiert oder gesperrt wurden, kann es an den folgenden Gründen liegen, warum Ihre Inhalte gemeldet oder entfernt worden sind:

• Meldung durch Nutzer: Wenn ausreichend Nutzer einen Post melden, kann dieser für eine Überprüfung markiert werden.

• Community-Standards: Jede Plattform verfügt über ihre eigenen Regeln, die definieren, was akzeptiert wird.

• Einhaltung der Gesetze: Die Plattformen müssen die nationalen Gesetze befolgen – Inhalte, die an einem Ort erlaubt sind, können an einem anderen Ort also verboten sein.

Tatsächliche Beispiele für Zensur in den sozialen Medien

Hier einige Beispiele für Fälle, in denen die Nutzer der Ansicht waren, dass die Moderatoren beim Zensieren oder Sperren zu weit gegangen sind:

1. Politische Inhalte: Posts über Proteste oder politische Bewegungen wurden aufgrund eines empfundenen Risikos oder Richtlinienkonflikts gelöscht.

2. Neutrale Berichterstattung: In manchen Fällen wurden Berichte von Journalisten entfernt, nur weil diese Terrororganisationen erwähnt haben.

3. Künstlerische Nacktheit: Kunst, insbesondere, wenn sie Nacktheit enthält, kann auf Plattformen mit Richtlinien zu Erwachseneninhalten gemeldet werden.

Was können Sie tun, wenn Sie betroffen sind?

Wenn Sie feststellen, dass Ihre Inhalte entfernt wurden und der Meinung sind, dass Zensur vorliegt, können Sie folgendes tun:

1. Widersprechen: Die meisten Plattformen verfügen über Widerspruchsmöglichkeiten. Nehmen Sie sich Zeit, um zu erklären, warum Sie der Ansicht sind, dass der Post nicht gegen die Richtlinien verstoßen hat.

2. Prüfen Sie die Community-Richtlinien: Wenn Sie sich mit den Regeln der Plattform vertraut machen, verstehen Sie besser, was passiert ist, und können künftige Probleme vermeiden.

3. Ziehen Sie Alternativen in Betracht: Für Nutzer, die mehr Kontrolle über ihre Inhalte möchten, könnten andere Plattformen passendere Moderationsrichtlinien bieten.

Schlussfolgerung

Auch wenn manche Moderationsentscheidungen zu Inhalten in den sozialen Medien wie Zensur wirken können, ist es hilfreich, bei der Nutzung der Plattformen deren Regeln zu kennen. Soziale Medien entwickeln sich immer weiter, weswegen es wichtig ist, deren Grenzen zu kennen, um Inhalte auf verschiedenen Plattformen bereitstellen zu können.

Melden von Inhalten

Social-Media-Plattformen stellen Tools bereit, mit deren Hilfe Nutzer potenziell schädliche Inhalte melden können, um eine sichere und einladende Umgebung zu schaffen.

Diese Tools ermöglichen es den Nutzern, Inhalte zu melden, die sie anstößig oder schädlich finden, oder die gegen die Community-Richtlinien verstoßen, so wie Hassrede, anstößiges Material, Fehlinformationen oder Belästigung.

Nachdem Inhalte gemeldet wurden, werden diese in der Regel geprüft, oft mit Hilfe automatisierter Systeme und menschlicher Moderatoren, um festzustellen, ob sie entfernt oder eingeschränkt werden sollten. Durch die Melde-Tools können die Plattformen nicht nur schneller auf potenziell problematische Inhalte reagieren, sondern auch ein Gefühl der gemeinsamen Verantwortung der Community schaffen, da die Nutzer bei der Entstehung einer sicheren Online-Umgebung eine wichtige Rolle spielen.

Quellen

https://transparency.meta.com/policies/community-standards/

https://www.youtube.com/intl/ALL_ie/howyoutubeworks/policies/community-guidelines/

https://www.tiktok.com/safety/en

https://support.google.com/youtube/answer/7554338?hl=en-GB