Las plataformas de redes sociales cuentan con miles de millones de usuarios en todo el mundo y se enfrentan a inmensos desafíos para garantizar que el contenido se alinee con las normas comunitarias, los requisitos legales y las consideraciones éticas. La moderación de contenido incluye los procesos que se usan para revisar, filtrar y potencialmente restringir o eliminar material perjudicial o inapropiado, y así poder fomentar entornos en línea seguros y tolerantes.

Dado el alcance y la influencia que tienen estas plataformas, las decisiones de moderación tienen importantes implicaciones sociales, éticas y legales. En este blog se proporciona una guía para comprender mejor el panorama de la moderación de contenido. Cubre las motivaciones subyacentes de las políticas de contenido, los procesos implicados y el complejo equilibrio que supone el fomento de la libre expresión y el mantenimiento de los estándares de seguridad. A medida que exploremos el “por qué” y el “cómo” de la moderación de contenido, podremos arrojar algo de luz sobre las prácticas y desafíos que definen esta área fundamental de la gobernanza digital.

¿Qué se suele prohibir en las redes sociales?

Las plataformas de redes sociales generalmente prohíben el contenido que infrinja sus normas comunitarias, estándares legales o ambos. Estas son algunas categorías comunes de contenido prohibido:

1. Lenguaje que incita al odio y acoso: es contenido que fomenta la discriminación, el odio o la violencia contra personas o grupos en función de atributos como la raza, etnia, religión, género u orientación sexual.

2. Violencia y amenazas: son publicaciones que incitan, amenazan o glorifican la violencia, incluidas amenazas para causar daño a personas, comunidades o grupos.

3. Contenido para adultos y explotación sexual: si bien algunas plataformas permiten formas limitadas de contenido para adultos, la mayoría prohíbe el material sexual explícito. Todas las plataformas prohíben la explotación sexual infantil y la difusión de imágenes íntimas sin consentimiento.

4. Desinformación: la información falsa que pueda causar daño (por ejemplo, información errónea relacionada con la salud o campañas de desinformación durante las elecciones) puede estar restringida o marcada.

5. Terrorismo y extremismo violento: contenido que promueva organizaciones terroristas, extremismo violento o contenido que glorifique el terrorismo o busque reclutar individuos para causas violentas.

6. Contenido sobre autolesiones y suicidio: el material que fomenta o glorifica la autolesión, el suicidio o los trastornos alimenticios a menudo se elimina o se marca; además, se proporcionan recursos de ayuda.

7. Actividades ilegales: publicaciones que muestren actividades ilegales, como tráfico de drogas, tráfico de personas o venta de sustancias y armas prohibidas.

8. Contenido dañino o engañoso: esto incluye estafas, fraudes, phishing o cualquier contenido destinado a engañar a los usuarios o aprovecharse de ellos, como obsequios falsos o la suplantación de identidad.

Otras áreas en las que las plataformas suelen establecer políticas incluyen las infracciones de propiedad intelectual. Generalmente, el contenido con derechos de autor o marca registrada (por ejemplo, películas o música pirateadas o la reproducción no autorizada de obras artísticas) se prohíbe para evitar infracciones. Las plataformas también suelen tener políticas sobre spam y contenido engañoso. Esto incluye contenido de spam, vínculos engañosos o “clickbait” que interrumpen la experiencia del usuario o conducen a los usuarios a sitios potencialmente dañinos.

Cada plataforma tiene sus propias políticas y sistemas de cumplimiento de normas, que pueden evolucionar en respuesta a las regulaciones, las preocupaciones sociales y el comportamiento emergente en línea.

A menudo, las plataformas eliminan contenido para proteger a los usuarios de material dañino, como los ejemplos enumerados anteriormente. Eliminar contenido permite a las plataformas evitar responsabilidades legales por hospedar material ilegal, como contenido que infringe los derechos de autor o material que promueve la violencia. Asimismo, al moderar el contenido, las plataformas pueden equilibrar la necesidad de preservar la libertad de expresión con la responsabilidad de proteger a los usuarios y mantener un espacio positivo para que los usuarios puedan participar y expresarse.

El Centro de apelaciones europeo es quien se ha encargado de redactar las descripciones y los métodos de aplicación de las reglas de Facebook, TikTok y YouTube que se detallan en este blog, en función de las políticas de las plataformas que se publicaron en noviembre de 2024.

Recuerde que este artículo se ha redactado únicamente con fines informativos y que no constituye una fuente de asesoramiento legal o profesional. Si quiere conocer las versiones actuales de las políticas de las plataformas, consulte los vínculos que tiene a continuación:

Por qué estamos aquí

El Centro de apelaciones europeo se creó para ayudar a los usuarios a gestionar e impugnar las decisiones sobre contenido que toman las plataformas de redes sociales, ofreciéndoles más transparencia, equidad y control sobre las plataformas que tanto les gustan y que usan a diario.

Si quiere impugnar una decisión de Facebook, TikTok o YouTube sobre algún contenido, puede presentar una apelación mediante nuestro portal.

Eliminación de contenido en Facebook: Qué significa y cómo gestionarlo

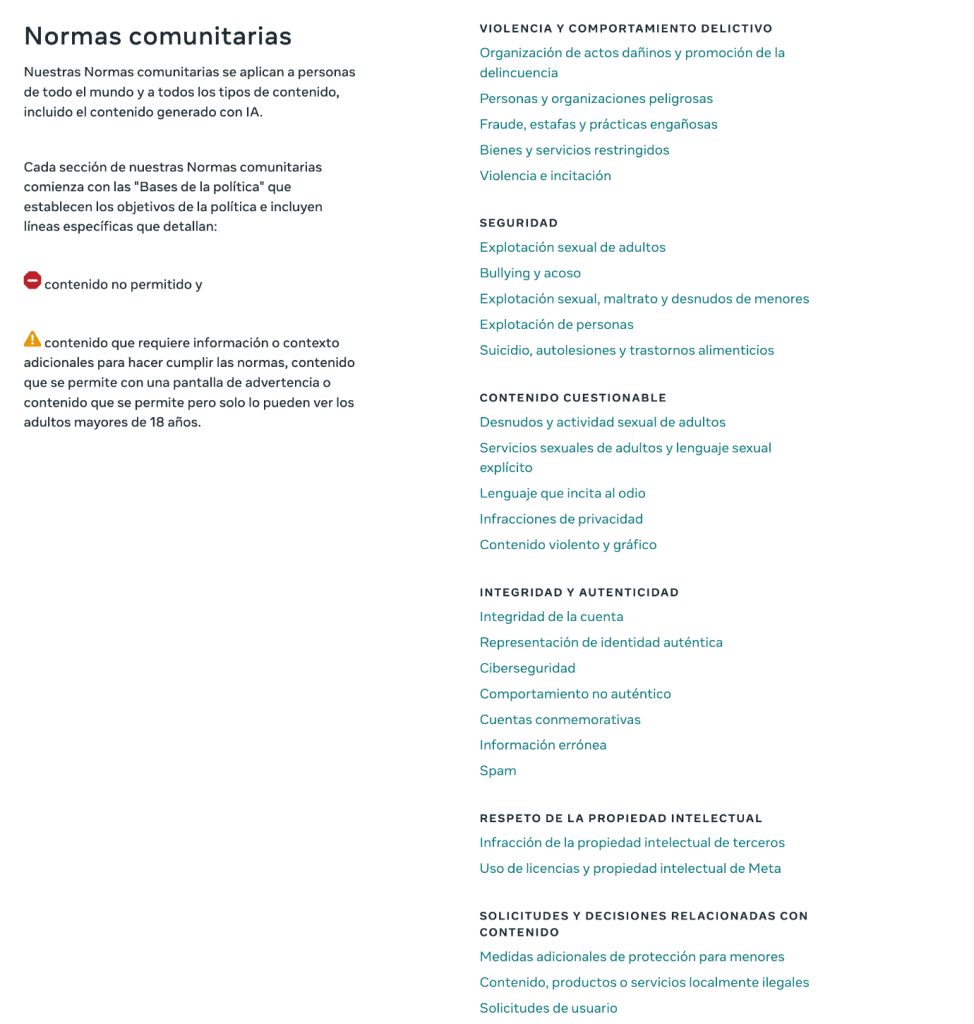

Desde el 12 de noviembre de 2024, Meta ha unificado las Normas comunitarias que se usan para evaluar el contenido de sus plataformas, incluidas Facebook e Instagram.

El proceso de eliminación de contenido de Meta es complejo y, a veces, parece que las reglas no son demasiado claras. A continuación, puede encontrar algunos motivos por los que se elimina cierto contenido.

Por qué Facebook elimina contenido

Facebook elimina o limita contenido que podría percibirse como una infracción de sus reglas sobre lo siguiente:

• Violencia y conducta criminal

• Seguridad

• Contenido ofensivo

• Integridad y autenticidad

• Respeto de la propiedad intelectual

• Solicitudes y decisiones relacionadas con el contenido que incluyan a menores, regulaciones locales y solicitudes de usuarios

Puede ver la lista completa de políticas aquí

¿Cómo marca Facebook el contenido?

Facebook utiliza una combinación de IA (inteligencia artificial) y moderadores humanos formados para analizar y revisar las publicaciones. A continuación tiene un breve resumen de cómo funciona:

• Detección de IA: los sistemas automatizados se establecen como la primera línea de defensa. Analizan el contenido en busca de posibles infracciones y marcan las publicaciones relacionadas con lenguaje o imágenes que podrían resultar ofensivos.

• Moderación humana: si la IA no está segura de la situación, los moderadores humanos intervienen para examinar el caso al detalle y tomar una decisión final.

Cómo apelar la eliminación de contenido en Facebook

Apelar es más fácil de lo que imagina. Estos son los pasos que debe seguir si cree que Facebook tomó la decisión equivocada:

1. Compruebe sus notificaciones: recibirá una notificación cuando se elimine su contenido. Normalmente se incluye una opción para apelar en la notificación.

2. Apele la decisión de Facebook: la bandeja de entrada del servicio de soporte de Facebook realiza un seguimiento de sus apelaciones y proporciona actualizaciones de estado. Siga estos pasos para apelar la decisión de Facebook mediante su mecanismo de quejas interno.

3. Si después de estos pasos sigue recibiendo una respuesta negativa sobre la decisión de moderación de contenido, puede presentar su apelación en el Centro de apelaciones europeo. Tendrá que proporcionar su número de referencia de Facebook e información adicional, y presentarlos en nuestro sitio web una vez que inicie un conflicto.

Cómo apelar la decisión de eliminación de contenido de Facebook

Si reside en la Unión Europea, puede presentar una apelación a través de nuestro portal. Aceptamos decisiones sobre contenido en todos los idiomas que se hablan en la UE, pero tenga en cuenta que deberá presentar su reclamación en inglés, alemán, francés, holandés, italiano o español. Si desea obtener más información sobre el Centro de apelaciones europeo, visite nuestra página de inicio.

Si no puede encontrar su número de referencia, consulte esta guía.

Iniciar una apelación: cómo encontrar su número de referencia de Facebook

Si su publicación, imagen, vídeo o comentario ha sido eliminado de Facebook, o si ha encontrado contenido que cree que debería eliminarse, tendrá que proporcionar un número de referencia de Facebook para iniciar el proceso de apelación.

Este número nos permite solicitar detalles a Facebook sobre su decisión. Sin él no podremos revisar la apelación.

Para ayudarle a gestionar este proceso, hemos creado esta guía detallada.

Qué es un número de referencia de Facebook y cómo encontrarlo

Cuando Facebook elimina su contenido, o si denuncia el contenido de otra persona, recibirá una notificación con la explicación de la decisión que se haya tomado.

Si reside en la UE, este mensaje debe incluir información sobre los organismos de resolución de conflictos y su número de referencia de Facebook.

Normalmente, el mensaje se encuentra en uno de los siguientes lugares:

• Estado del perfil: inicie sesión en Facebook y revise las notificaciones de su cuenta.

• Página de inicio del soporte para empresas (cuentas de negocios): inicie sesión en su instancia de Business Suite para buscar los mensajes apropiados.

¿Qué pasa si no puedo encontrar mi número de referencia de Facebook?

No hay problema. Existe otra forma de recuperarlo. Puede solicitar un número de referencia de Facebook directamente a Meta mediante estos pasos:

1. Haga clic en este vínculo de solicitud de número de referencia de Meta.

2. Inicie sesión en su cuenta de Facebook.

3. Rellene los datos necesarios en el formulario.

Una vez que complete el formulario, Meta le proporcionará el número de referencia que necesita.

¿Cómo se presenta el número de referencia de Facebook?

Una vez que tenga su número de referencia, vaya a nuestro Portal de casos para comenzar con la apelación. En el paso 2: información de la plataforma, seleccione “Facebook” en el menú desplegable. Aparecerá un campo donde podrá introducir su número de referencia de Facebook.

Este paso es crucial para garantizar la continuidad de su apelación.

Dónde encontrar más ayuda

Podemos ofrecerle la ayuda que necesite durante todo el proceso:

• Consulte la guía detallada de Meta sobre los números de referencia de Facebook.

• Siga nuestra página de Facebook para obtener más consejos, guías y actualizaciones sobre los derechos digitales y la moderación de contenido. Dar el primer paso en una apelación puede resultar abrumador, pero con las herramientas y el apoyo adecuados, resolverá su caso con facilidad.

Por qué TikTok elimina vídeos (y cómo se puede apelar)

A veces, el proceso de moderación de TikTok puede provocar eliminaciones inesperadas de vídeos. Si eliminaron su vídeo y no sabe por qué, ¡no se preocupe! Aquí puede ver por qué TikTok elimina vídeos, cómo puede apelar y qué debe tener en cuenta para mantener activo su contenido.

Por qué TikTok elimina vídeos

TikTok sigue un conjunto detallado de normas comunitarias, entre las que se incluyen los principales motivos que llevan a una eliminación:

• Lenguaje que incita al odio y acoso: el contenido que se ensaña con grupos o individuos específicos puede ser eliminado.

• Contenido violento o gráfico: TikTok no permite material gráfico o explícito, incluso si forma parte de una noticia.

• Desinformación: TikTok elimina contenido que pueda ser engañoso.

Cómo modera TikTok el contenido

Estos son algunos detalles sobre qué hace TikTok para revisar las publicaciones:

• Detección mediante IA: existen sistemas automatizados que marcan el contenido en función de determinadas palabras clave y patrones.

• Moderadores humanos: si un vídeo marcado no es claro, los moderadores intervienen para realizar una revisión final.

Cómo apelar la eliminación de contenido en TikTok

Si cree que su vídeo no debería haber sido eliminado, puede presentar una apelación en la aplicación:

1. Compruebe sus notificaciones: TikTok le notificará el motivo por el cual se eliminó el vídeo.

2. Presente una apelación: en la misma notificación, tendrá disponible una opción para apelar y compartir más contexto.

3. Seguimiento de la apelación: puede comprobar el estado de su apelación en la misma aplicación.

Evitar futuras eliminaciones en TikTok

Para evitar eliminaciones, no emplee lenguaje ni elementos visuales que puedan desencadenar revisiones de la IA, especialmente si se trata de temas delicados. Tenga en cuenta estos consejos y podrá mantener su contenido activo y disfrutar de una experiencia más fluida en TikTok.

Más información

Le animamos a consultar las normas comunitarias de TikTok. En ellas encontrará detalles que explican cómo se modera el contenido de esta plataforma:

Eliminación de contenido en YouTube: por qué sucede y qué se puede hacer

Si es un creador de vídeos en YouTube, que eliminen un vídeo puede ser un contratiempo importante, especialmente si no sabe por qué sucedió.

Por qué YouTube elimina vídeos

YouTube tiene una serie de normas comunitarias diseñadas para mantener una plataforma segura y atractiva. Estos son algunos motivos clave por los que podrían eliminar sus vídeos:

• Contenido dañino: generalmente se marcan los vídeos que fomentan actividades peligrosas o dañan a otros.

• Contenido violento o gráfico: YouTube no permite violencia explícita ni material gráfico.

• Spam y desinformación: podrá eliminarse el contenido que difunda información engañosa, especialmente sobre temas como la salud.

¿Cómo decide YouTube el contenido que se queda y el que se elimina?

YouTube utiliza dos herramientas principales:

• Detección automatizada: la IA analiza el contenido en busca de señales de alerta, como acrobacias peligrosas o imágenes prohibidas.

• Denuncias de usuarios: los usuarios pueden denunciar vídeos y, si una cantidad suficiente de personas marca un vídeo, es posible que un moderador lo revise.

Cómo apelar si YouTube elimina su vídeo

Si eliminan su vídeo y no está de acuerdo, puede presentar una apelación sobre esa decisión. Aquí tiene una guía rápida:

1. Compruebe su correo electrónico: normalmente, YouTube envía un correo electrónico con detalles sobre por qué se eliminó el vídeo.

2. Presente una apelación: acceda a YouTube Studio, busque su vídeo y explique por qué cree que no infringe ninguna regla.

3. Póngase en contacto con el equipo de soporte técnico (si es necesario): para casos complejos, es posible que quiera contactar directamente con el soporte técnico de YouTube.

Consejos para garantizar la seguridad de sus vídeos

Para evitar que eliminen su contenido, consulte periódicamente las normas de YouTube, especialmente si va a tratar temas delicados. Esto le permitirá mantener su contenido activo y evitar interrupciones inesperadas.

Normas comunitarias de YouTube

¿Cuándo se convierte la moderación de contenido en censura?

A medida que evolucionan las redes sociales, también lo hace el debate sobre la censura. Si bien plataformas como Facebook, TikTok y YouTube moderan el contenido para ofrecer un entorno seguro y mantener una experiencia de usuario positiva, es posible que los usuarios se sientan limitados debido a la censura.

A veces, la moderación de contenido en las redes sociales puede parecer censura o una prohibición injustificada o inexplicable. Aquí analizaremos cómo funciona la moderación de contenido en las redes sociales y, para ello, compartiremos algunos ejemplos reales y detallaremos qué hacer si se ve afectado.

Por qué se modera el contenido en las redes sociales

Si cree que ha sufrido algún tipo censura o que han prohibido su contenido sin justificación en las redes sociales, aquí tiene algunos motivos comunes por los que el contenido se marca o elimina:

• Denuncias de usuarios: cuando una cantidad suficiente de usuarios denuncia una publicación, esta se marca para su revisión.

• Normas comunitarias: cada plataforma tiene su propio conjunto de reglas que definen lo que es aceptable.

• Cumplimiento legal: las plataformas deben cumplir las leyes nacionales, por lo que el contenido que es aceptable en un lugar podría estar restringido en otro.

Ejemplos reales de censura en las redes sociales

Estos son algunos ejemplos en los que los usuarios pensaron que la moderación fue demasiado lejos y pasó a censurar o prohibir contenido:

1. Contenido político: publicaciones eliminadas sobre protestas o movimientos políticos debido a riesgos percibidos o conflictos con las políticas.

2. Periodismo objetivo: en algunos casos, se han eliminado artículos de periodistas en las redes sociales porque simplemente mencionaban organizaciones terroristas.

3. Desnudez artística: el arte, especialmente si incluye desnudez, puede marcarse en plataformas que tengan políticas sobre contenido para adultos.

Qué hacer si se ve afectado

Si descubre que su contenido se ha eliminado y cree que es debido a la censura, aquí tiene algunos consejos rápidos:

1. Apelación: la mayoría de las plataformas le permiten apelar. Tómese su tiempo para explicar por qué cree que la publicación no infringe las normas.

2. Revise las normas comunitarias: familiarícese con las reglas de la plataforma para comprender mejor qué sucedió y así evitar problemas futuros.

3. Considere otras alternativas: si es de esos usuarios que quieren tener más control sobre su contenido, otras plataformas ofrecen políticas de moderación diferentes.

Conclusión

Aunque la moderación de contenido de las redes sociales pueda parecer censura, conocer las reglas puede ayudarle a navegar por estas plataformas con confianza. Las redes sociales están en constante evolución y ser consciente de sus límites puede ayudarle a compartir contenido de manera responsable en diferentes plataformas.

Marcar contenido

Las plataformas de redes sociales ofrecen herramientas que permiten a los usuarios marcar contenido potencialmente dañino como parte de sus esfuerzos por mantener un entorno seguro y tolerante.

Estas herramientas permiten a los usuarios denunciar contenido que consideren ofensivo, dañino o que infrinja las normas comunitarias; por ejemplo, lenguaje que incita al odio, material explícito, desinformación o acoso.

Una vez que se marca el contenido, normalmente pasa por un proceso de revisión para evaluar si debe eliminarse o restringirse; este proceso emplea a menudo sistemas automatizados y moderadores humanos. Las herramientas para marcar contenido no solo permiten a las plataformas abordar con presteza el “contenido problemático”, sino que también fomentan un sentido de responsabilidad comunitaria, ya que los usuarios desempeñan un rol activo en la creación de entornos en línea más seguros.

Fuentes

https://transparency.meta.com/policies/community-standards/

https://www.youtube.com/intl/ALL_ie/howyoutubeworks/policies/community-guidelines/

https://www.tiktok.com/safety/en

https://support.google.com/youtube/answer/7554338?hl=en-GB