Avec des milliards d’utilisateurs dans le monde entier, les plateformes de réseaux sociaux peinent à s’assurer que le contenu publié demeure conforme aux standards de la communauté, aux exigences légales et aux considérations d’ordre éthique. La modération du contenu englobe les processus employés pour réviser, filtrer et éventuellement restreindre ou supprimer des éléments préjudiciables ou inappropriés afin de promouvoir des environnements en ligne qui soient à la fois sûrs et respectueux.

Au vu de la portée et de l’influence de ces plateformes, les décisions en matière de contenu ont d’importantes implications sur le plan social, éthique et juridique. Cet article de blog a pour but d’aider à mieux comprendre le contexte de la modération du contenu. Il décrit les facteurs sous-jacents qui motivent les politiques de contenu, les processus impliqués et l’équilibre complexe entre la défense de la liberté d’expression et le maintien de normes de sécurité. En étudiant le « pourquoi » et le « comment » de la modération du contenu, cet article vise à apporter quelques éclairages sur les pratiques et les défis qui caractérisent cet aspect fondamental de la gouvernance numérique.

Quels sont, d’une manière générale, les contenus interdits sur les réseaux sociaux ?

Les plateformes de réseaux sociaux interdisent généralement tout contenu enfreignant les standards de la communauté et/ou la réglementation. Voici quelques catégories courantes de contenu interdit :

1. Discours incitant à la haine et harcèlement : contenu qui encourage la discrimination, la haine ou la violence à l’encontre de personnes ou de groupes de personnes, sur la base de critères tels que la race, l’origine ethnique, la religion, le sexe ou l’orientation sexuelle.

2. Violence et menaces : publications à caractère menaçant, qui incitent à la violence ou la glorifient (par exemple, des menaces préjudiciables à l’encontre de personnes, de communautés ou de groupes).

3. Contenu pour adultes et exploitation sexuelle : bien que certaines plateformes autorisent certaines formes limitées de contenu pour adultes, la plupart interdisent les contenus explicites à caractère sexuel. Toutes les plateformes interdisent formellement l’exploitation sexuelle des enfants et les images pornographiques non consenties.

4. Fausse information et désinformation : les informations erronées potentiellement préjudiciables (fausse information d’ordre sanitaire ou campagnes de désinformation en période électorale, par exemple) peuvent faire l’objet d’une restriction ou d’un signalement.

5. Terrorisme et extrémisme violent : contenu de nature à promouvoir les organisations terroristes ou l’extrémisme violent, ou contenu qui glorifie le terrorisme ou cherche à recruter des individus pour défendre des causes violentes.

6. Automutilation et suicide : les contenus qui encouragent ou glorifient l’automutilation, le suicide ou les troubles alimentaires sont souvent supprimés ou signalés ; des ressources de soutien sont généralement proposées en parallèle.

7. Activités illégales : publications impliquant des activités illégales, telles que le trafic de drogue, le trafic d’êtres humains ou la vente de substances prohibées et d’armes.

8. Contenu préjudiciable ou trompeur : arnaques, fraude, hameçonnage ou tout contenu visant à tromper ou à exploiter les utilisateurs, telles que les fausses récompenses ou l’usurpation d’identité.

Les violations de la propriété intellectuelle sont également réglementées par les plateformes. Les contenus protégés par des droits d’auteur ou par des marques déposées sont généralement interdits afin d’éviter toute violation. Il peut s’agir, par exemple, de films ou musiques piratés ou d’une reproduction non autorisée d’œuvres artistiques. Par ailleurs, les plateformes ont souvent mis en place des politiques autour des contenus indésirables et trompeurs. Ces restrictions concernent le contenu indésirable (spam), les liens frauduleux ou le clickbait qui nuit à l’expérience utilisateur ou redirige les utilisateurs vers des sites potentiellement malveillants.

Chaque plateforme possède ses propres politiques et ses propres pratiques de mise en application, qui peuvent évoluer en fonction de la réglementation, de préoccupations sociétales et de comportements en ligne émergents.

Les plateformes suppriment souvent du contenu pour protéger leurs utilisateurs des publications préjudiciables telles que celles énumérées ci-dessus. La suppression de contenu est un moyen pour les plateformes d’éviter d’engager leur responsabilité juridique pour avoir hébergé du contenu illicite (en violation avec des droits d’auteurs ou de nature à promouvoir la violence, par exemple). La modération de contenu leur permet de trouver un juste équilibre entre la nécessité de défendre la liberté d’expression et leur devoir de protéger les utilisateurs et de préserver un espace positif dans lequel les utilisateurs peuvent interagir et s’exprimer.

Les descriptions des règles établies par Facebook, TikTok et YouTube contenues dans cet article de blog, de même que leurs modalités de mise en application, ont été rédigées par l’Appeals Centre Europe qui s’est inspiré des politiques publiées par les plateformes en novembre 2024.

Nous attirons votre attention sur le fait que cet article a été rédigé uniquement à titre d’information et qu’il ne saurait en aucun cas être interprété comme un avis juridique ou professionnel. Pour consulter les versions en vigueur de ces politiques, voir les liens ci-dessous :

Notre mission

L’Appels Centre Europe a été instauré dans le but d’aider les utilisateurs à prendre connaissance des décisions prises par les plateformes de réseaux sociaux en matière de contenu et à les contester, de manière à offrir aux internautes davantage de transparence, d’équité et de contrôle sur les plateformes qu’ils apprécient et qu’ils utilisent au quotidien.

Si vous êtes en désaccord avec une décision relative au contenu prise par Facebook, TikTok ou YouTube, vous pouvez faire appel de cette décision via notre portail.

Suppression de contenu sur Facebook : implications et modalités

Depuis le 12 novembre 2024, Meta a unifié les standards de la communauté appliqués pour évaluer le contenu publié sur ses plateformes, notamment Facebook et Instagram.

La suppression de contenu par Meta est un processus complexe, qui peut parfois donner le sentiment de règles alambiquées. Vous trouverez ci-dessous quelques raisons justifiant la suppression de certains types de contenus.

Motifs justifiant la suppression de contenu sur Facebook

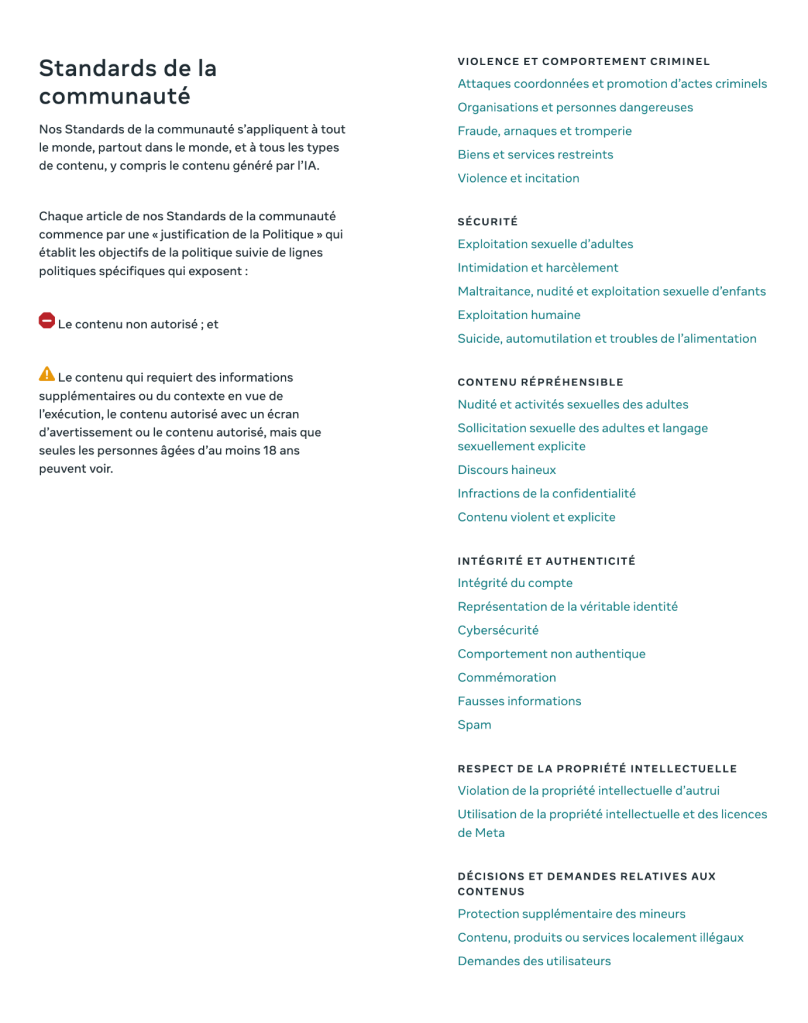

Facebook supprime ou restreint les contenus qui peuvent être perçus comme étant contraires à ses règles en matière de :

• Violence et comportement criminel

• Sécurité

• Contenu répréhensible

• Intégrité et authenticité

• Respect de la propriété intellectuelle

• Demandes et décisions en lien avec du contenu impliquant des mineurs, liées à la réglementation locale ou à des demandes d’utilisateurs

Cliquez ici pour accéder à la liste complète des politiques

Signalement de contenu sur Facebook

Pour analyser et vérifier les publications, Facebook utilise l’IA (intelligence artificielle) et a recours, en parallèle, à des modérateurs humains qualifiés. En voici le principe de fonctionnement en quelques lignes :

• Détection par l’IA : les systèmes automatisés constituent la première ligne de défense. Ils sont là pour analyser le contenu afin de détecter d’éventuelles violations et pour signaler les publications qui contiennent des propos ou des images interdits.

• Modération humaine : si l’IA émet des doutes, les modérateurs humains interviennent pour examiner la situation de plus près et prendre une décision définitive.

Comment contester la suppression d’un contenu sur Facebook

Faire appel d’une décision est plus simple que vous ne pourriez le croire ! Voici la procédure à suivre si vous estimez que Facebook a rendu une décision contestable :

1. Vérifiez vos notifications : vous recevez une notification à chaque suppression de contenu. Cette notification contient généralement une option permettant de faire appel de cette décision.

2. Contestez la décision de Facebook : la boîte de réception d’assistance de Facebook suit l’avancée de vos appels et fournit des mises à jour sur l’état d’avancement de la procédure. Suivez ces étapes pour utiliser le mécanisme de réclamation interne de Facebook afin de faire appel de cette décision.

3. Si, après avoir suivi cette procédure, vous continuez à recevoir une réponse négative au sujet de la décision de modération du contenu, vous avez la possibilité de faire appel auprès de l’Appeals Centre Europe. Muni de votre numéro de référence Facebook, il vous suffira de nous transmettre quelques informations supplémentaires via notre site Web après avoir initié une procédure de litige.

Comment contester une décision de suppression de contenu prise par Facebook

Si vous résidez au sein de l’Union européenne, rendez-vous simplement sur notre portail pour faire appel. Bien que nous acceptions d’étudier les décisions prises au sujet de contenus publiés dans toutes les langues de l’UE, notez cependant que vous devrez rédiger votre demande d’appel uniquement en anglais, en allemand, en français, en néerlandais, en italien ou en espagnol. Pour en savoir plus sur l’Appeals Centre Europe, nous vous invitons à consulter notre page d’accueil.

Si vous ne trouvez pas votre numéro de référence, consultez ce guide.

Déclencher une procédure d’appel – Comment trouver votre numéro de référence Facebook

Si l’un(e) de vos publications, images, vidéos ou commentaires a été supprimé(e) de Facebook, ou si vous avez rencontré un contenu qui, selon vous, mériterait d’être supprimé, vous devez nous communiquer un numéro de référence Facebook pour engager la procédure d’appel.

Ce numéro nous permet de demander à Facebook des détails concernant sa décision. Sans ce numéro, nous ne serons pas en mesure d’étudier votre litige.

Pour vous aider tout au long de ce processus, nous avons rédigé ce guide pas à pas.

Qu’est-ce qu’un numéro de référence Facebook et comment le trouver ?

Lorsque Facebook supprime votre contenu, ou si vous signalez le contenu d’une autre personne, la plateforme vous envoie une notification détaillant sa décision.

Si vous résidez dans l’UE, ce message contiendra des informations sur les organismes de règlement des litiges, accompagnées de votre numéro de référence Facebook.

Ce message figure généralement à l’un des emplacements suivants :

• Statut du profil : connectez-vous à Facebook et vérifiez les notifications sur votre compte.

• Accueil assistance business (pour les comptes professionnels) : connectez-vous à votre Business Suite pour accéder aux messages.

Que faire si je ne trouve pas mon numéro de référence Facebook ?

Pas d’inquiétude, il existe un autre moyen de le récupérer. Vous pouvez demander votre numéro de référence Facebook directement à Meta en suivant simplement cette procédure :

1. Cliquez sur ce lien de demande de numéro de référence Meta.

2. Connectez-vous à votre compte Facebook.

3. Renseignez les champs obligatoires du formulaire.

Une fois le formulaire rempli, Meta vous communiquera le numéro de référence dont vous avez besoin.

Comment soumettre un numéro de référence Facebook ?

Une fois que vous disposez de votre numéro de référence, rendez-vous sur notre portail de gestion de cas pour initier la procédure d’appel. À l’Étape 2 : Informations sur la plateforme, sélectionnez « Facebook » dans le menu déroulant. Saisissez votre numéro de référence Facebook dans le champ qui s’affiche.

Cette étape est cruciale pour nous permettre de traiter votre demande.

Où trouver de l’aide supplémentaire ?

Pour obtenir de l’aide tout au long du processus, consultez les ressources suivantes si vous avez besoin d’une assistance supplémentaire :

• Consultez le guide détaillé de Meta sur les numéros de référence Facebook.

• Suivez notre page Facebook pour obtenir d’autres astuces, ainsi que des guides et des mises à jour sur les droits numériques et la modération du contenu. Il peut être assez décourageant de se lancer dans une procédure d’appel, mais avec les bons outils et l’assistance adéquate, vous avez toutes les cartes en main pour résoudre votre cas.

Pourquoi la plateforme TikTok supprime-t-elle des vidéos (et comment faire appel) ?

Le processus de modération adopté par TikTok peut parfois conduire à des suppressions de vidéos inattendues. Si votre vidéo a été supprimée pour une raison qui vous semble confuse, sachez que vous n’êtes pas seul(e) ! Voyons ensemble pourquoi TikTok supprime des vidéos, comment faire appel de cette décision et ce que vous devez prendre en compte pour avoir la garantie que votre contenu reste en ligne.

Motifs justifiant la suppression de vidéos sur TikTok

TikTok suit un ensemble détaillé de Règles de la communauté qui expose les principales raisons justifiant la suppression de vidéos, à savoir :

• Discours incitant à la haine et harcèlement : tout contenu qui cible des groupes ou des personnes spécifiques peut être supprimé.

• Contenu violent ou graphique : TikTok n’autorise aucun contenu graphique ou explicite, même s’ils ont pour but d’informer.

• Fausse information : TikTok supprime les contenus potentiellement trompeurs.

L’approche de la modération de contenu par TikTok

Voici en substance la procédure de révision des publications adoptée par TikTok :

• Détection par l’IA : les systèmes automatisés signalent du contenu en fonction de certains mots-clés ou schémas.

• Modérateurs humains : en cas de doute sur une vidéo signalée, des modérateurs interviennent pour un examen final.

Comment contester la suppression d’une vidéo sur TikTok

Si vous avez pensé que la décision de suppression est infondée, vous pouvez faire appel via l’application en suivant la procédure ci-dessous :

1. Vérifiez vos notifications : TikTok vous informera du motif de suppression de votre vidéo.

2. Faire appel : la notification contient une option permettant de faire appel et de partager davantage de contexte.

3. Suivre l’avancée de l’appel : vous pouvez vérifier le statut d’avancement de votre appel dans l’application.

Comment éviter de futures suppressions sur TikTok

Pour éviter les suppressions de vidéos, n’employez aucun propos ou visuel susceptible de déclencher un examen par l’IA, en particulier en ce qui concerne les sujets sensibles. Ne perdez pas de vue ces quelques conseils pour pouvoir continuer à publier du contenu et profiter d’une meilleure expérience sur TikTok.

Conseils de lecture

Nous vous invitons à parcours les Règles de la communauté TikTok, qui expliquent leur approche de la modération de contenu :

Suppression de contenu sur YouTube : motifs et vos moyens d’action

Si vous êtes un créateur de contenu sur YouTube, le retrait d’une vidéo peut être une lourde déconvenue pour un youtubeur, surtout si les raisons restent floues.

Pourquoi YouTube supprime des vidéos

YouTube a instauré des Règles de la communauté dont le but est de préserver la sécurité et l’attractivité de la plateforme. Vous trouverez ci-dessus quelques-unes des principales raisons pouvant justifier la suppression de vidéos :

• Contenu préjudiciable : les vidéos qui encouragent les activités dangereuses ou qui portent préjudice à des tiers sont généralement signalées.

• Contenu graphique ou violent : YouTube ne tolère ni violence ni image explicites.

• Spam et fausse information : tout contenu ayant vocation à propager des informations trompeuses, en particulier sur des sujets tels que la santé, peut être supprimé.

Comment la plateforme YouTube décide-t-elle du contenu à conserver ou à supprimer ?

YouTube utilise deux principaux outils :

• Détection automatisée : l’IA analyse le contenu à la recherche d’indicateurs justifiant une suppression (cascades dangereuses ou images prohibées, par exemple).

• Signalements d’utilisateurs : les utilisateurs ont la possibilité de signaler des vidéos, qui peuvent être examinées par un modérateur si elles reçoivent suffisamment de signalements.

Comment faire appel d’une décision de suppression de vidéo sur YouTube

Si votre vidéo est supprimée et que vous contestez cette décision, vous avez la possibilité de faire appel. Voici un guide rapide expliquant la procédure à suivre :

1. Vérifiez vos e-mails : YouTube envoie généralement un e-mail expliquant pourquoi votre vidéo a été supprimée.

2. Faire appel : recherchez votre vidéo dans YouTube Studio et expliquez pourquoi, selon vous, elle n’enfreint aucune règle.

3. Contactez le support (si besoin) : pour les cas complexes, il peut être utile de s’adresser directement à l’équipe de support YouTube.

Conseils pour protéger vos vidéos

Pour éviter la suppression de contenu, nous vous conseillons de consulter régulièrement les règles de YouTube, en particulier si vous abordez des sujets sensibles. Cette simple précaution est un bon moyen de maintenir vos vidéos en ligne et d’éviter les interruptions inattendues.

Règles de la communauté YouTube

À quel moment la modération du contenu s’apparente-t-elle à de la censure ?

À mesure que les réseaux sociaux évoluent, le débat autour de la censure prend une tout autre tournure. Les plateformes telles que Facebook, TikTok et YouTube justifient leur modération de contenu par leur volonté d’offrir un environnement sûr et de maintenir une expérience utilisateur positive. Pour autant, certains utilisateurs ont le sentiment que cette censure limite leur liberté d’expression.

La modération du contenu sur les réseaux sociaux peut parfois donner l’impression de s’apparenter à une censure ou une interdiction sans fondement ni explication. Nous allons ici décortiquer le fonctionnement de la modération du contenu sur les réseaux sociaux, donner quelques exemples concrets et passer en revue les recours dont vous disposez si vous vous sentez concerné(e).

Pourquoi les réseaux sociaux sont-ils soumis à une modération du contenu ?

Si vous pensez que vous avez été victime à tort d’une censure ou d’une exclusion sur les réseaux sociaux, voici quelques raisons courantes justifiant le signalement ou la suppression de contenu :

• Signalements d’utilisateurs : lorsqu’une publication est signalée par un nombre suffisant d’utilisateurs, elle est marquée pour faire l’objet d’un examen.

• Standards de la communauté : chaque plateforme dispose de ses propres règles pour définir ce qui est acceptable.

• Conformité à la législation : les plateformes étant tenues de se conformer à la législation nationale, un contenu réputé acceptable dans un pays peut être soumise à des restrictions dans d’autres.

Exemples concrets de censure sur les réseaux sociaux

Voici quelques exemples de situations où les utilisateurs ont eu le sentiment que la modération est allée trop loin, au point de s’apparenter à de la censure ou à de l’interdiction de contenu :

1. Contenu politique : des publications au sujet de protestations ou de mouvements politiques ont été supprimées en raison des risques perçus ou au motif d’un conflit potentiel avec les politiques en vigueur.

2. Articles neutres : il est arrivé parfois que des articles de journalistes publiés sur les réseaux sociaux aient été supprimés pour la simple raison qu’ils mentionnaient des organisations terroristes.

3. Nudité artistique : l’art, en particulier s’il met en scène la nudité, peut être signalé sur les plateformes pour violation des politiques en matière de contenu pour adultes.

Que faire si vous êtes concerné(e)

Si vous pensez avoir été censuré(e) dans le cadre de la suppression d’un contenu, voici quelques conseils à suivre :

1. Faites appel : la plupart des plateformes vous offrent la possibilité de faire appel. Prenez le temps d’expliquer pourquoi vous pensez que votre publication n’enfreint pas leurs règles.

2. Examinez les Règles de la communauté : familiarisez-vous avec les règles de la plateforme pour mieux comprendre ce qu’il s’est passé et éviter tout problème ultérieur.

3. Envisagez des solutions alternatives : pour les utilisateurs qui cherchent à obtenir davantage de contrôle sur le contenu qu’ils publient, d’autres plateformes peuvent prévoir des politiques de modération différentes.

Conclusion

Bien que la modération du contenu sur les réseaux sociaux puisse être interprétée comme une forme de censure, il est important de connaître les règles pour utiliser les plateformes en toute confiance. Les réseaux sociaux ne cessent d’évoluer, et c’est en connaissant les limites à ne pas franchir que vous pourrez partager du contenu de manière responsable sur les différentes plateformes.

Signalement de contenu

Dans le cadre de leurs efforts visant à promouvoir un environnement sûr et accueillant, les plateformes de réseaux sociaux proposent des outils qui permettent aux utilisateurs de signaler du contenu potentiellement préjudiciable.

Ces outils permettent aux utilisateurs de signaler tout contenu qu’ils jugeraient insultant, répréhensible ou contraire aux règles de la communauté, tels que des discours incitant à la haine, des contenus explicites, de fausses informations ou du harcèlement.

Une fois le contenu signalé, il est généralement soumis à un processus de révision (qui implique souvent l’intervention de systèmes automatisés et de modérateurs humains) afin d’évaluer s’il convient de le supprimer ou de le restreindre. En plus d’aider les plateformes à réagir plus rapidement aux « contenus problématiques », les outils de signalement éveillent un sens de la responsabilité communautaire, dans la mesure où les utilisateurs contribuent activement à façonner un espace en ligne plus sûr.

Sources

https://transparency.meta.com/policies/community-standards/

https://www.youtube.com/intl/ALL_ie/howyoutubeworks/policies/community-guidelines/

https://www.tiktok.com/safety/en

https://support.google.com/youtube/answer/7554338?hl=en-GB