Le piattaforme di social media, con miliardi di utenti in tutto il mondo, affrontano sfide considerevoli per garantire che i contenuti siano in linea con gli standard della community, i requisiti legali e le considerazioni etiche. Le attività di moderazione dei contenuti comprendono i processi utilizzati per esaminare, filtrare e potenzialmente limitare, ed eventualmente rimuovere, il materiale dannoso o inappropriato, al fine di favorire ambienti online sicuri e rispettosi.

Data la portata e l’influenza di queste piattaforme, le decisioni di moderazione hanno importanti implicazioni sociali, etiche e legali. Questo blog funge da guida per comprendere il panorama della moderazione dei contenuti, tratta le motivazioni alla base delle politiche sui contenuti, i processi coinvolti e il delicato equilibrio tra la valorizzazione della libertà di espressione e il mantenimento degli standard di sicurezza. Analizzando il “perché” e il “come” della moderazione dei contenuti, il blog mira a far luce sulle pratiche e sulle sfide che definiscono quest’area essenziale della governance digitale.

Normalmente, cosa viene vietato sui social media?

Solitamente le piattaforme di social media vietano i contenuti che violano le linee guida della community, gli standard legali o entrambi. Di seguito sono elencate alcune categorie comuni di contenuti vietati:

1. Discorsi d’odio e molestie: contenuti che promuovono la discriminazione, l’odio o la violenza nei confronti di individui o gruppi in base ad aspetti quali la razza, l’etnia, la religione, il genere o l’orientamento sessuale.

2. Violenza e minacce: post che incitano alla violenza, ne minacciano l’uso o la glorificano, comprese le minacce rivolte a singoli individui, comunità o gruppi.

3. Contenuto per adulti e strumentalizzazione sessuale: sebbene alcune piattaforme consentano forme limitate di contenuti per adulti, la maggior parte proibisce il materiale sessualmente esplicito. Tutte le piattaforme vietano lo sfruttamento sessuale di minori e la diffusione di immagini intime non consensuali.

4. Informazioni false e disinformazione: le informazioni non veritiere che possono arrecare danni, come ad esempio false informazioni in materia di salute o le campagne di disinformazione in occasione delle elezioni, potrebbero essere limitate o segnalate.

5. Terrorismo ed estremismo violento: contenuti che promuovono organizzazioni terroristiche, estremismo violento o contenuti che esaltano il terrorismo o cercano di reclutare individui a scopo di violenza.

6. Contenuti relativi ad autolesionismo e suicidio: il materiale che incoraggia o esalta l’autolesionismo, il suicidio o i disturbi alimentari viene spesso rimosso o segnalato e vengono messe a disposizione risorse di supporto.

7. Attività illegali: post che riguardano attività illegali, come il traffico di droga, la tratta di esseri umani o la vendita di sostanze illecite e armi.

8. Contenuti dannosi o ingannevoli: ciò comprende truffe, frodi, phishing o qualsiasi contenuto destinato a ingannare o strumentalizzare gli utenti, come falsi omaggi o impersonificazioni.

Tra gli altri ambiti per cui le piattaforme prevedono spesso delle politiche rientrano le violazioni della proprietà intellettuale. I contenuti protetti da copyright o da marchi registrati, come i film piratati, la musica o la riproduzione non autorizzata di opere artistiche, sono in genere vietati per prevenire le violazioni. Spesso le piattaforme hanno anche politiche che riguardano gli spam e i contenuti fuorvianti. Questa sezione riguarda contenuti spam, link ingannevoli o clickbait che compromettono l’esperienza dell’utente o lo inducono a visitare siti potenzialmente dannosi.

Ogni piattaforma ha le proprie politiche e procedure di attuazione delle stesse, che possono cambiare a seconda delle normative vigenti, delle esigenze della società e dei nuovi atteggiamenti online.

Di frequente le piattaforme provvedono a rimuovere i contenuti per proteggere gli utenti da materiali dannosi come quelli precedentemente elencati. Rimuovere i contenuti può permettere alle piattaforme di evitare responsabilità legali derivanti dall’aver ospitato materiale illegale, come ad esempio contenuti che violano il diritto d’autore o che promuovono la violenza. Grazie alla moderazione dei contenuti, le piattaforme possono conciliare l’esigenza di libera espressione con la propria responsabilità di tutelare gli utenti e garantire uno spazio positivo di interazione e di espressione degli stessi.

Le descrizioni delle regole di Facebook, TikTok e YouTube (e delle relative modalità di applicazione) riportate in questo blog sono state redatte dall’Appeals Centre Europe sulla base delle politiche delle piattaforme pubblicate a novembre 2024.

Ricordiamo che il presente articolo è stato redatto a scopo puramente informativo e non costituisce una consulenza legale o professionale. Per conoscere le versioni aggiornate delle politiche delle piattaforme, consulta i link sottostanti:

Perché esistiamo?

L’Appeals Centre Europe è stato costituito per aiutare gli utenti a orientarsi e a contestare le decisioni sui contenuti prese dalle piattaforme di social media, garantendo ai cittadini maggiore trasparenza, imparzialità e controllo sulle piattaforme che amano e utilizzano quotidianamente.

Se ti trovi in disaccordo con una decisione presa da Facebook, TikTok o YouTube in merito a un contenuto, puoi presentare un ricorso tramite il nostro portale.

Rimozione dei contenuti da Facebook: Cosa significa e come la gestiamo

Dal 12 novembre 2024 Meta ha uniformato gli Standard della community adottati per la valutazione dei contenuti sulle sue piattaforme, tra cui Facebook e Instagram.

Il processo di rimozione dei contenuti di Meta è alquanto intricato e a volte potrebbe sembrare che le regole non siano del tutto immediate. Di seguito potrai trovare alcuni dei motivi che portano alla rimozione di alcuni contenuti.

Perché Facebook rimuove i contenuti?

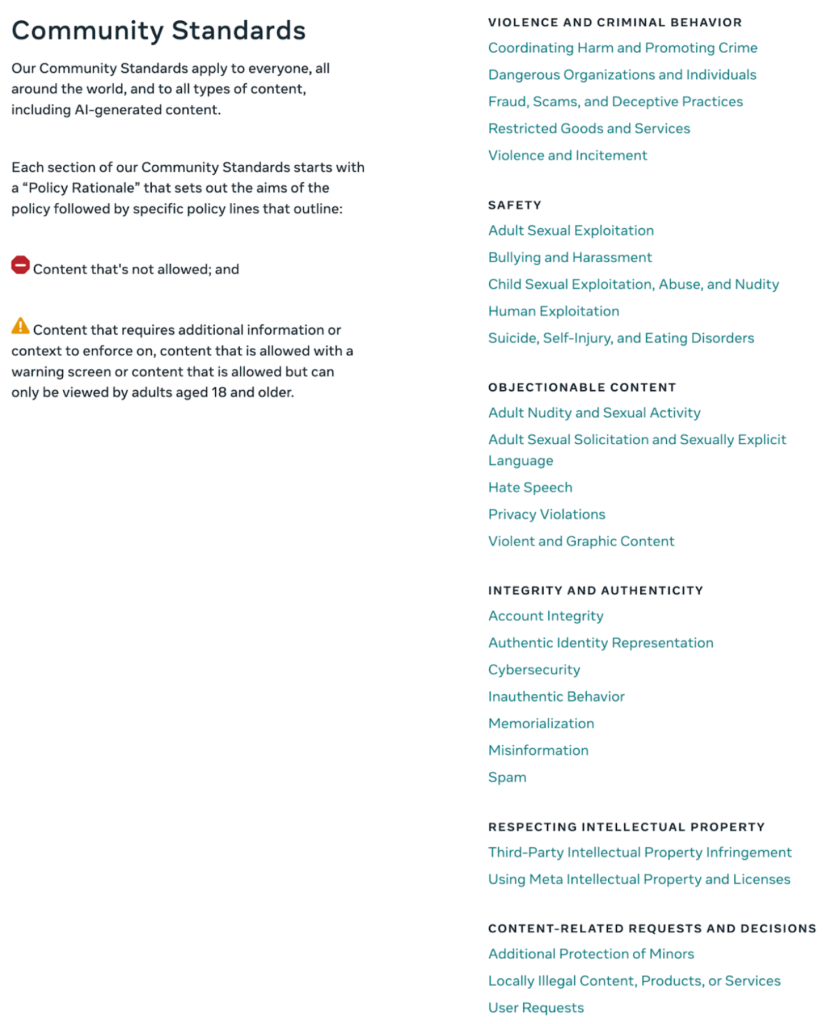

Facebook rimuove o limita i contenuti che potrebbero essere ritenuti in contrasto con le sue regole in materia di:

• violenza e comportamenti criminali;

• sicurezza;

• contenuti opinabili;

• integrità e autenticità;

• rispetto della proprietà intellettuale;

• richieste e decisioni inerenti ai contenuti che coinvolgono i minori, le normative locali e le esigenze degli utenti.

Puoi trovare l’elenco completo delle politiche qui

Come segnala i contenuti Facebook?

Facebook utilizza un connubio di intelligenza artificiale (IA) e di moderatori umani debitamente formati per analizzare ed esaminare i post. Ecco velocemente come funziona:

• Rilevamento con IA: i sistemi automatici rappresentano la prima linea difensiva. Esaminano i contenuti alla ricerca di potenziali violazioni, segnalando i post contenenti elementi linguistici, o di immagine, inappropriati.

• Moderazione umana: laddove l’IA dovesse avere delle incertezze, entrano in gioco i moderatori umani che esaminano la situazione in maniera più approfondita e prendono una decisione definitiva.

Come impugnare la rimozione di un contenuto su Facebook

Fare ricorso è più facile di quanto credi! Ecco cosa devi fare se pensi che Facebook abbia commesso un errore:

1. Controlla le notifiche: quando un contenuto viene rimosso ricevi una notifica. Solitamente nel messaggio dovresti vedere l’opzione per fare ricorso.

2. Ricorso alla decisione di Facebook: la casella di posta elettronica dell’assistenza di Facebook tiene traccia dei ricorsi e provvede ad aggiornarne lo stato. Segui questa procedura per impugnare la decisione di Facebook ricorrendo al relativo meccanismo di reclamo interno.

3. Qualora, a seguito di questi passaggi, dovessi ricevere ancora una risposta negativa in merito alla decisione di moderazione del contenuto, potrai appellarti all’Appeals Centre Europe. Dovrai essere in possesso del tuo numero di riferimento di Facebook e di alcune altre informazioni che potrai inviare tramite il nostro sito nel momento in cui avvierai una controversia.

Come impugnare una decisione di rimozione di contenuti da parte di Facebook

Se ti trovi nell’Unione europea puoi presentare un ricorso tramite il nostro portale. Benché accettiamo decisioni sui contenuti in tutte le lingue parlate nell’UE, la controversia dovrà essere presentata in inglese, tedesco, francese, olandese, italiano o spagnolo. Per maggiori informazioni sull’Appeals Centre Europe, visita la nostra pagina.

Se non riesci a trovare il tuo numero di riferimento, consulta questa guida.

Avvia una controversia – Dove trovare il tuo numero di riferimento di Facebook

Se il tuo post, immagine, video o commento è stato rimosso da Facebook, o se hai trovato un contenuto che ritieni debba essere rimosso, dovrai fornirci un numero di riferimento di Facebook per avviare la procedura di ricorso.

Questo numero ti permette di richiedere i dettagli a Facebook relativi alla decisione che hanno preso e senza questo numero non saremo in grado di revisionare il tuo ricorso.

Abbiamo creato una guida dettagliata per aiutarti durante questo procedimento.

Cos’è un numero di riferimento di Facebook e come puoi trovarlo?

Quando Facebook rimuove il tuo contenuto, o se segnali il contenuto di qualcun altro, riceverai una notifica in cui vengono delineati i motivi della decisione presa dalla piattaforma.

Se ti trovi nell’Unione europea, tale notifica dovrebbe includere informazioni relative agli organismi di risoluzione delle controversie e il tuo numero di riferimento di Facebook.

Generalmente, puoi trovare questo messaggio in uno dei seguenti posti:

• Stato del profilo: accedi a Facebook e controlla le notifiche sul tuo account.

• Home dell’assistenza delle aziende (per gli account aziendali): Accedi alla tua Business Suite per visualizzare i messaggi importanti.

Cosa succede se non riesco a trovare il mio numero di riferimento di Facebook?

Nessun problema, c’è un altro modo per recuperarlo. Puoi richiedere il numero di riferimento di Facebook direttamente a Meta seguendo questi passaggi:

1. Fai clic su questo link per richiedere il numero di riferimento Meta.

2. Accedi al tuo account Facebook.

3. Compila i campi richiesti nel modulo.

Una volta compilato il modulo, Meta ti fornirà il numero di riferimento di cui hai bisogno.

Come si invia il numero di riferimento di Facebook?

Una volta in possesso del numero di riferimento, vai sul nostro Portale dei casi per avviare il ricorso. Nel Passaggio 2: Informazioni della piattaforma, seleziona “Facebook” dal menu a discesa. Comparirà un campo in cui potrai inserire il tuo numero di riferimento di Facebook.

Questo passaggio è fondamentale per garantire che possiamo procedere con il tuo ricorso.

Dove posso trovare ulteriori aiuti?

Se hai bisogno di ulteriore assistenza, per aiutarti a gestire l’intero processo:

• consulta la guida dettagliata di Meta sui numeri di riferimento di Facebook;

• segui la nostra pagina Facebook per ulteriori suggerimenti, guide o aggiornamenti sui diritti digitali e sulla moderazione dei contenuti. Intraprendere una procedura di ricorso può sembrare un’impresa opprimente, ma con gli strumenti e il supporto giusti, sarai sulla buona strada per risolvere il tuo caso.

Perché TikTok rimuove i video (e come puoi fare ricorso)?

Il processo di moderazione di TikTok a volte può portare alla rimozione inattesa di alcuni video. Se il tuo video è stato rimosso e non sai perché, altre persone hanno lo stesso problema! Scopriamo insieme perché TikTok rimuove i video, come fare ricorso e cosa tenere a mente per non far rimuovere il proprio contenuto.

Perché TikTok rimuove i video?

TikTok segue delle Linee guida della community molto dettagliate, complete di motivazioni determinanti riguardo la rimozione dei contenuti, tra cui:

• Discorsi d’odio e molestie: contenuti che prendono di mira gruppi specifici o individui possono essere rimossi.

• Contenuti violenti o espliciti: TikTok non permette la pubblicazione di materiale esplicito, neanche se concepito come notizia.

• False informazioni: TikTok rimuove i contenuti che potrebbero essere fuorvianti.

Come modera i contenuti TikTok?

Ecco come TikTok esamina i post:

• Rilevamento con IA: i sistemi automatici segnalano il contenuto sulla base di determinate parole chiave e schemi.

• Moderatori umani: se un video segnalato non è chiaro intervengono i moderatori per un’analisi finale.

Come impugnare la rimozione di un video su TikTok

Se ritieni che un tuo video non dovesse essere rimosso, puoi presentare un ricorso nell’app:

1. Controlla le notifiche: TikTok ti invierà una notifica con il motivo per cui il tuo video è stato rimosso.

2. Presenta un ricorso: nella notifica che ti viene inviata troverai l’opzione per presentare un ricorso e fornire un contesto più dettagliato.

3. Monitora il ricorso: puoi controllare lo stato del tuo ricorso dall’app.

Evitare rimozioni future su TikTok

Per evitare la rimozione dei contenuti, utilizza un linguaggio e delle immagini che non inneschino la revisione dell’IA, in particolare relativamente ad argomenti sensibili. Tenendo a mente questi suggerimenti i tuoi contenuti rimarranno attivi e potrai goderti un’esperienza più gradevole su TikTok.

Leggi di più

Ti invitiamo a consultare le linee guida della community di TikTok in cui viene spiegato come vengono moderati i contenuti sulla piattaforma:

Rimozione dei contenuti da YouTube: Perché succede e cosa puoi fare a riguardo?

Se sei un creator di YouTube la rimozione di un tuo video può avere un impatto significativo, in particolare se non sai a cosa sia dovuta.

Perché YouTube elimina i video?

Le linee guida della community di YouTube sono pensate per mantenere la piattaforma un posto sicuro e stimolante. Di seguito alcune delle ragioni principali per cui un video può essere rimosso:

• Contenuto dannoso: solitamente, i video che promuovono attività pericolose o che arrecano danni agli altri vengono segnalati.

• Contenuti violenti o espliciti: atti di violenza espliciti o immagini crude non sono permessi su YouTube.

• Spam e false informazioni: i contenuti che divulgano informazioni fuorvianti, soprattutto su argomenti come la salute, possono essere rimossi.

Come fa YouTube a decidere cosa può essere lasciato e cosa no?

YouTube si affida a due strumenti principali:

• Rilevamento automatico: l’intelligenza artificiale analizza i contenuti alla ricerca di indicatori di pericolo, come esibizioni pericolose o immagini vietate.

• Segnalazioni degli utenti: gli spettatori possono segnalare i video. Se un video viene segnalato da abbastanza persone, può essere revisionato da un moderatore.

Come impugnare la rimozione di un video da parte di YouTube

Se non sei d’accordo con la rimozione di un tuo video, puoi avviare una controversia. Ecco una breve guida:

1. Controlla le tue e-mail: solitamente YouTube invia un’e-mail in cui delinea la motivazione dietro la rimozione del tuo video.

2. Avvia un ricorso: collegati a YouTube Studio, trova il tuo video e spiega perché pensi che sia conforme alle regole della piattaforma.

3. Contatta l’assistenza (se necessario): per i casi complicati potresti dover consultare direttamente il team di assistenza di YouTube.

Suggerimenti per mantenere i tuoi video al sicuro

Per evitare che i tuoi contenuti vengano rimossi dovresti controllare regolarmente le linee guida di YouTube, soprattutto tratti argomenti delicati. In questo modo potrai mantenere i tuoi contenuti online ed evitare spiacevoli interruzioni.

Linee guida della community di YouTube

Quando la moderazione dei contenuti diventa censura?

Con l’evolversi dei social media, si evolve anche il dibattito sulla censura. Benché piattaforme come Facebook, TikTok e YouTube dichiarino di moderare i contenuti per fornire un ambiente sicuro e assicurare un’esperienza positiva agli utenti, talvolta questi ultimi ritengono che la censura ostacoli la loro libertà di espressione.

A volte, la moderazione dei contenuti sui social media può essere percepita come una censura o un divieto immotivato o inspiegabile. Analizziamo insieme come funziona la moderazione dei contenuti sui social media, alcuni esempi di vita reale e come puoi comportarti se dovesse capitarti.

Perché sui social media si ricorre alla moderazione dei contenuti?

Se ritieni di aver subito una censura o un divieto ingiustificato sui social media, di seguito troverai alcuni motivi comuni per cui un contenuto potrebbe essere stato segnalato o rimosso:

• Segnalazioni degli utenti: quando abbastanza utenti segnalano un post, quest’ultimo viene contrassegnato per una revisione.

• Standard della community: ogni piattaforma ha il proprio insieme di regole che stabiliscono cosa sia accettabile e cosa no.

• Conformità legale: le piattaforme devono attenersi alle leggi nazionali, ciò significa che i contenuti che possono andare bene in un luogo potrebbero essere sottoposti a restrizioni in un altro.

Esempi reali di censura sui social media

Di seguito sono riportati alcuni esempi in cui gli utenti hanno ritenuto che la moderazione si fosse spinta oltre trasformandosi in censura o blocco dei contenuti:

1. Contenuti politici: i post su proteste o movimenti politici sono stati rimossi a fronte di un rischio percepito o di un contrasto con le politiche della piattaforma.

2. Segnalazione neutrale: in alcuni casi, i reportage dei giornalisti sui social media sono stati rimossi solo per aver nominato organizzazioni terroristiche.

3. Nudo artistico: l’arte, in particolare se include nudità, può essere segnalata sulle piattaforme che adottano politiche sui contenuti per adulti.

Cosa puoi fare se ciò ti riguarda?

Se ti accorgi che i tuoi contenuti sono stati rimossi, e ritieni di aver subito una censura, ecco alcuni rapidi consigli:

1. Ricorso: la maggior parte delle piattaforme ti permette di fare ricorso. Prenditi il tempo per spiegare come mai ritieni che il tuo post non violi le loro linee guida.

2. Rivedere le linee guida della comunità: prendere confidenza con le regole della piattaforma può aiutare comprendere le motivazioni di quanto successo e a evitare problemi futuri.

3. Considerare delle alternative: per gli utenti che desiderano un maggiore controllo sui propri contenuti, esistono altre piattaforme che prevedono politiche di moderazione diverse.

Conclusione

Per quanto la moderazione dei contenuti sui social media possa sembrare una censura, avere una conoscenza delle regole può aiutarti a navigare con sicurezza sulle piattaforme. I social media sono in continua evoluzione e conoscerne i confini può aiutarti a condividere in modo responsabile sulle diverse piattaforme.

Segnalare i contenuti

Le piattaforme di social media mettono a disposizione degli utenti strumenti che consentono di segnalare i contenuti potenzialmente dannosi al fine di mantenere un ambiente sicuro e accogliente.

Tali strumenti permettono agli utenti di segnalare i contenuti che ritengono offensivi, dannosi o che violano le linee guida della community, come i discorsi d’odio, il materiale esplicito, le informazioni false o le molestie.

In genere, una volta segnalati, i contenuti vengono sottoposti a un processo di revisione, che spesso coinvolge sistemi automatici e moderatori umani, volto a valutare se debbano essere rimossi o limitati. Gli strumenti di segnalazione aiutano le piattaforme non solo a intervenire più rapidamente sui “contenuti problematici”, ma anche a favorire un senso di responsabilità della community, in quanto gli utenti giocano un ruolo importante nella creazione di uno spazio online più sicuro.

Fonti

https://transparency.meta.com/policies/community-standards/

https://www.youtube.com/intl/ALL_ie/howyoutubeworks/policies/community-guidelines/

https://www.tiktok.com/safety/en

https://support.google.com/youtube/answer/7554338?hl=en-GB