Met miljarden gebruikers over de hele wereld staan socialemediaplatforms voor immense uitdagingen om ervoor te zorgen dat inhoud in overeenstemming is met communitynormen, wettelijke vereisten en ethische overwegingen. Inhoudsmoderatie omvat de processen die worden gebruikt om schadelijk of ongepast materiaal te beoordelen, te filteren en mogelijk te beperken of te verwijderen om veilige en respectvolle onlineomgevingen te bevorderen.

Gezien het bereik en de invloed van deze platforms hebben moderatiebeslissingen belangrijke sociale, ethische en juridische implicaties. Dit blog biedt een handleiding om het terrein van inhoudsmoderatie te begrijpen. Het behandelt de onderliggende motivaties voor inhoudsbeleid, de processen die erbij komen kijken en de complexe balans tussen het bevorderen van vrije meningsuiting en het handhaven van veiligheidsnormen. Door het ‘waarom’ en ‘hoe’ van inhoudsmoderatie te onderzoeken, wil het licht werpen op de praktijken en uitdagingen die dit essentiële gebied van digitaal bestuur definiëren.

Wat is over het algemeen verboden op sociale media?

Socialemediaplatforms verbieden doorgaans inhoud die hun communityrichtlijnen, wettelijke normen of beide schendt. Hier zijn enkele veelvoorkomende categorieën van verboden inhoud:

1. Haatzaaien en intimidatie: Inhoud die discriminatie, haat of geweld tegen individuen of groepen promoot op basis van kenmerken zoals ras, etniciteit, religie, geslacht of seksuele geaardheid.

2. Geweld en bedreigingen: Berichten die aanzetten tot, dreigen met geweld of dit verheerlijken, inclusief dreigementen met schade aan individuen, gemeenschappen of groepen.

3. Inhoud voor volwassenen en seksuele uitbuiting: Hoewel sommige platforms beperkte vormen van inhoud voor volwassenen toestaan, verbieden de meeste platforms expliciet seksueel materiaal. Alle platforms verbieden seksuele uitbuiting van kinderen en niet-consensueel intiem beeldmateriaal.

4. Misinformatie en desinformatie: Valse informatie die schade kan veroorzaken, zoals verkeerde informatie over gezondheid of desinformatiecampagnes tijdens verkiezingen, kan worden beperkt of gemarkeerd.

5. Terrorisme en gewelddadig extremisme: Inhoud die terroristische organisaties of gewelddadig extremisme promoot of inhoud die terrorisme verheerlijkt of mensen probeert te rekruteren voor gewelddadige doelen.

6. Inhoud over zelfbeschadiging en zelfdoding: Materiaal dat zelfbeschadiging, zelfdoding of eetstoornissen aanmoedigt of verheerlijkt, wordt vaak verwijderd of gemarkeerd en er worden ondersteunende bronnen aangeboden.

7. Illegale Aktivitäten: Posts, die illegale Aktivitäten wie Drogen- oder Menschenschmuggel oder den Verkauf verbotener Substanzen oder Waffen betreffen.

8. Schadelijke of misleidende inhoud: Dit omvat oplichting, fraude, phishing of inhoud die bedoeld is om gebruikers te misleiden of uit te buiten, zoals nepweggeefacties of imitatie.

Andere gebieden waarop platforms vaak beleid hebben, zijn onder andere schendingen van intellectueel eigendom. Inhoud met auteursrechten of handelsmerken, zoals illegaal gekopieerde films, muziek of ongeautoriseerde reproductie van artistieke werken, wordt meestal verboden om inbreuk te voorkomen. Platforms hebben ook vaak een beleid rond spam en misleidende inhoud. Hieronder vallen spaminhoud, misleidende links of clickbait die de gebruikerservaring verstoren of gebruikers misleiden naar mogelijk schadelijke sites.

Elk platform heeft zijn eigen beleid en handhavingspraktijken, die kunnen evolueren als reactie op regelgeving, maatschappelijke bezorgdheid en opkomend online gedrag.

Platforms verwijderen vaak inhoud om gebruikers te beschermen tegen schadelijk materiaal zoals hierboven vermeld. Het verwijderen van inhoud kan platforms helpen om wettelijke aansprakelijkheid te voorkomen voor het hosten van onwettig materiaal, zoals inhoud die inbreuk maakt op auteursrechten of materiaal dat geweld promoot. Door inhoud te modereren kunnen platforms een evenwicht vinden tussen de behoefte aan vrije expressie en hun verantwoordelijkheid om gebruikers te beschermen, en een positieve ruimte voor engagement en expressie van gebruikers te behouden.

De beschrijvingen van de regels van Facebook, TikTok en YouTube (en hoe ze worden toegepast) in dit blog zijn opgesteld door het Appeals Centre Europe op basis van het beleid van de platforms dat in november 2024 is gepubliceerd.

Dit artikel is alleen bedoeld voor informatieve doeleinden en vormt geen juridisch of professioneel advies. Volg de onderstaande links voor actuele versies van het beleid van de platforms:

Waarom we bestaan

Het Appeals Centre Europe is opgericht om gebruikers te helpen bij het doorlopen en betwisten van beslissingen over inhoud van socialemediaplatforms, zodat mensen meer transparantie, eerlijkheid en controle krijgen over de platforms die ze leuk vinden en dagelijks gebruiken.

Als u het niet eens bent met een beslissing over inhoud door Facebook, TikTok of YouTube, kunt u een beroep indienen via onze portal.

Inhoud verwijderen op Facebook: Wat het betekent en hoe ermee om te gaan

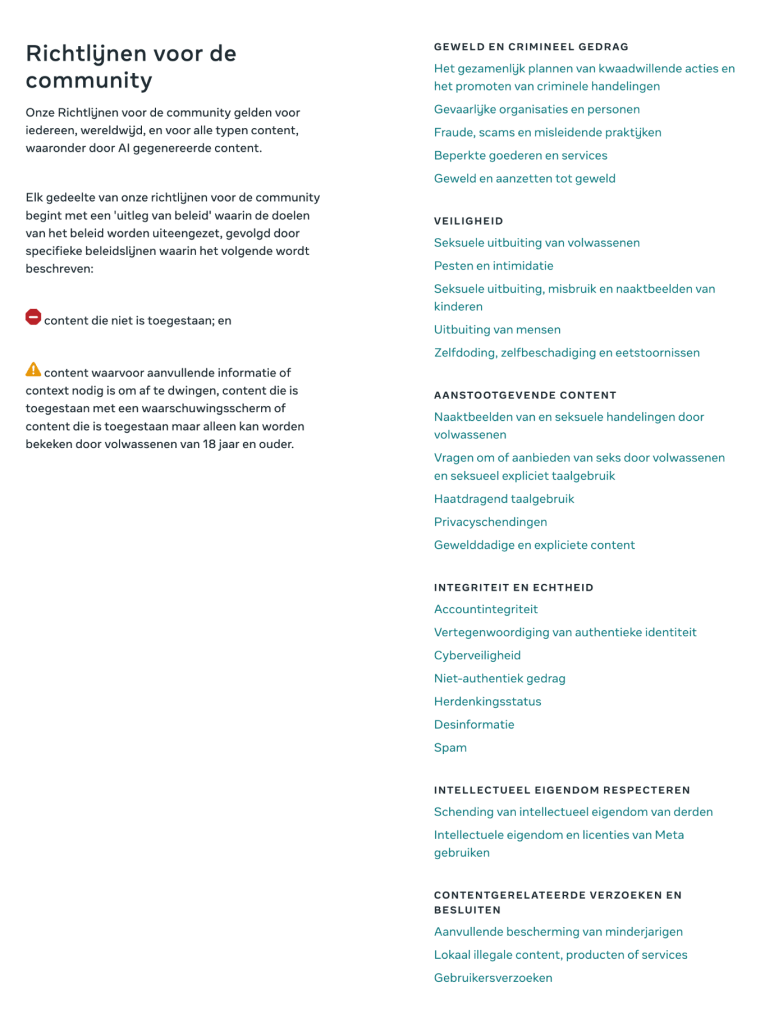

Sinds 12 november 2024 heeft Meta de Communitynormen die worden gebruikt voor het evalueren van inhoud op haar platforms, waaronder Facebook en Instagram, geïntegreerd.

Het verwijderingsproces voor inhoud van Meta is complex en soms lijkt het alsof de regels niet duidelijk zijn. Hieronder ziet u een aantal redenen waarom sommige inhoud wordt verwijderd.

Waarom Facebook inhoud verwijdert

Facebook verwijdert of beperkt inhoud die kan worden gezien als het overtreden van de regels voor:

• Geweld en crimineel gedrag

• Veiligheid

• Aanstootgevende inhoud

• Integriteit en authenticiteit

• Respecteren van intellectueel eigendom

• Inhoudgerelateerde verzoeken en beslissingen met betrekking tot minderjarigen, lokale regelgeving en gebruikersverzoeken

De volledige lijst met beleidsregels vindt u hier

Hoe markeert Facebook inhoud?

Facebook gebruikt een combinatie van AI (kunstmatige intelligentie) en getrainde menselijke moderators om berichten te scannen en te beoordelen. In het kort werkt dit als volgt:

• AI-detectie: Geautomatiseerde systemen vormen de eerste verdedigingslinie. Ze scannen inhoud op mogelijke overtredingen en markeren berichten met betrekking tot taalgebruik of afbeeldingen.

• Menselijke moderatie: Als de AI het niet zeker weet, gaan menselijke moderators de situatie nader onderzoeken en nemen ze een definitieve beslissing.

In beroep gaan tegen een verwijdering van inhoud op Facebook

In beroep gaan is makkelijker dan u misschien denkt. Ga als volgt te werk als Facebook volgens u de verkeerde beslissing heeft genomen:

1. Uw melding controleren: U ontvangt een melding wanneer inhoud wordt verwijderd. Deze omvat meestal een optie om in beroep te gaan.

2. Beroep aantekenen tegen de beslissing van Facebook: Facebooks Support Inbox houdt uw beroepen bij en biedt statusupdates. Volg deze stappen om in beroep te gaan tegen de beslissing van Facebook via hun interne klachtenmechanisme.

3. Als u na deze stappen nog steeds een negatieve reactie krijgt over de beslissing om de inhoud te modereren, kunt u in beroep gaan bij het Appeals Centre Europe. U hebt uw Facebook-referentienummer nodig en wat aanvullende informatie die u op onze website kunt indienen zodra u een geschil start.

In beroep gaan tegen een beslissing tot verwijdering van inhoud door Facebook

Als u zich in de Europese Unie bevindt, kunt u een beroep indienen via onze portal. Hoewel we beslissingen over inhoud accepteren in alle talen die in de EU worden gesproken, moet u uw geschil indienen in het Engels, Duits, Frans, Nederlands, Italiaans of Spaans. Ga naar onze startpagina voor meer informatie over het Appeals Centre Europe.

Raadpleeg deze handleiding als u uw referentienummer niet kunt vinden.

In beroep gaan – Hoe vind ik mijn Facebook-referentienummer?

Als uw bericht, afbeelding, video of opmerking is verwijderd van Facebook of als u inhoud tegenkomt waarvan u vindt dat deze moet worden verwijderd, moet u een Facebook-referentienummer aan ons doorgeven om de beroepsprocedure te starten.

Met dit nummer kunnen we Facebook om details vragen over hun beslissing. Zonder dit nummer kunnen we uw beroep niet beoordelen.

Om u te helpen bij dit proces, hebben we deze stapsgewijze handleiding gemaakt.

Wat is een Facebook-referentienummer en hoe vindt u dit?

Wanneer Facebook uw inhoud verwijdert of als u de inhoud van iemand anders meldt, sturen ze u een bericht met hun beslissing.

Als u in de EU woont, omvat dit informatie over instanties voor geschillenbeslechting en uw Facebook-referentienummer.

U vindt dit bericht meestal op een van de volgende plaatsen:

• Profielstatus: Log in op Facebook en controleer de meldingen in uw account.

• Startpagina zakelijke support (voor zakelijke accounts): Log in op uw Business Suite om de relevante berichten te vinden.

Wat moet ik doen als ik mijn Facebook-referentienummer niet kan vinden?

Geen probleem, er is een andere manier om dit op te halen. U kunt een Facebook-referentienummer rechtstreeks bij Meta aanvragen door deze stappen te volgen:

1. Klik op deze Meta-link voor het aanvragen van het referentienummer.

2. Log in op uw Facebook-account.

3. Vul de vereiste gegevens in op het formulier.

Zodra u het formulier hebt ingevuld, stuurt Meta u het benodigde referentienummer.

Hoe dien ik mijn Facebook-referentienummer in?

Zodra u uw referentienummer hebt, gaat u naar onze zaakportal om uw beroep te starten. Bij Stap 2: Platforminformatie, selecteert u Facebook in het vervolgkeuzemenu. Er verschijnt een veld waarin u uw Facebook-referentienummer kunt invoeren.

Deze stap is cruciaal om ervoor te zorgen dat we verder kunnen gaan met uw beroep.

Waar kunt u meer hulp vinden?

Om u tijdens het hele proces te ondersteunen als u meer hulp nodig hebt:

• Ga in de gedetailleerde handleiding van Meta naar Facebook-referentienummers.

• Volg onze Facebook-pagina voor meer tips, handleidingen en updates over digitale rechten en inhoudsmoderatie. De eerste stap in een beroep voelt misschien overweldigend, maar met de juiste hulpmiddelen en ondersteuning bent u al een heel eind op weg om uw zaak op te lossen.

Waarom TikTok video’s verwijdert (en hoe u in beroep kunt gaan)

Het moderatieproces van TikTok kan soms leiden tot onverwachte verwijderingen van video’s. Als uw video is verwijderd en u niet precies weet waarom, bent u niet de enige! Laten we eens kijken waarom TikTok video’s verwijdert, hoe u in beroep kunt gaan en waaraan u moet denken om uw inhoud live te houden.

Waarom TikTok video’s verwijdert

TikTok volgt een gedetailleerde reeks communityrichtlijnen, met belangrijke redenen voor verwijdering, waaronder:

• Haatzaaien en intimidatie: Inhoud die gericht is op specifieke groepen of individuen, kan worden verwijderd.

• Gewelddadige of grafische inhoud: TikTok staat geen grafisch of expliciet materiaal toe, zelfs niet als het bedoeld is als nieuws.

• Desinformatie: TikTok verwijdert inhoud die misleidend kan zijn.

Hoe TikTok inhoud modereert

Dit is hoe TikTok berichten beoordeelt:

• AI-detectie: Geautomatiseerde systemen markeren inhoud op basis van bepaalde trefwoorden en patronen.

• Menselijke moderators: Als een gemarkeerde video niet duidelijk is, geven moderators een laatste beoordeling.

In beroep gaan tegen een verwijdering van een TikTok-video

Als u vindt dat uw video niet verwijderd had mogen worden, kunt u hiertegen in beroep gaan in de app:

1. Uw meldingen controleren: TikTok laat u weten waarom uw video is verwijderd.

2. Een beroep indienen: Binnen de melding hebt u de mogelijkheid om in beroep te gaan en meer context te delen.

3. Het beroep volgen: U kunt de status van uw beroep controleren in de app.

Toekomstige verwijderingen op TikTok voorkomen

Om verwijderingen te voorkomen, moet u taal en afbeeldingen vermijden die AI-beoordelingen kunnen uitlokken, vooral bij gevoelige onderwerpen. Door deze tips in gedachten te houden, kunt u uw inhoud actief houden en genieten van een soepelere ervaring op TikTok.

Meer informatie

Lees de TikTok-communityrichtlijnen, hierin wordt uitgelegd hoe ze inhoud op hun platform modereren:

Inhoud verwijderen op YouTube: Waarom het gebeurt en wat u eraan kunt doen

Als u een YouTube-creator bent, kan het verwijderen van een video een behoorlijke tegenslag zijn, vooral als u niet precies weet waarom het is gebeurd.

Waarom YouTube video’s verwijdert

YouTube heeft communityrichtlijnen ontworpen om het platform veilig en aantrekkelijk te houden. Hier zijn enkele belangrijke redenen waarom video’s kunnen worden verwijderd:

• Schadelijke inhoud: Video’s die gevaarlijke activiteiten promoten of anderen schade toebrengen, worden meestal gemarkeerd.

• Grafische of gewelddadige inhoud: Expliciet geweld of grafische beelden zijn niet toegestaan op YouTube.

• Spam en desinformatie: Inhoud die misleidende informatie verspreidt, vooral over onderwerpen zoals gezondheid, kan worden verwijderd.

Hoe beslist YouTube wat blijft en wat verdwijnt?

YouTube vertrouwt op twee belangrijke tools:

• Geautomatiseerde detectie: AI scant inhoud op rode vlaggen, zoals gevaarlijke stunts of verboden beeldmateriaal.

• Rapporten van gebruikers: Kijkers kunnen video’s rapporteren en als genoeg mensen een video markeren, kan deze worden bekeken door een moderator.

In beroep gaan als YouTube uw video verwijdert

Als uw video is verwijderd en u bent het er niet mee eens, dan kunt u in beroep gaan tegen de beslissing. Hier volgt een korte procedure:

1. Uw e-mail controleren: YouTube stuurt meestal een e-mail waarin wordt uitgelegd waarom uw video is verwijderd.

2. Een beroep indienen: Ga naar YouTube Studio, zoek uw video en leg uit waarom deze volgens u geen regels schendt.

3. Contact opnemen met ondersteuning (indien nodig): Voor complexe gevallen kunt u het beste direct contact opnemen met het ondersteuningsteam van YouTube.

Tips om uw video’s veilig te houden

Om te voorkomen dat uw inhoud wordt verwijderd, moet u regelmatig de richtlijnen van YouTube controleren, vooral als u gevoelige onderwerpen behandelt. Zo blijft uw inhoud online en voorkomt u onverwachte onderbrekingen.

De communityrichtlijnen van YouTube

Wanneer wordt inhoudsmoderatie censuur?

Naarmate sociale media zich ontwikkelen, is er ook steeds meer discussie over censuur. Hoewel platforms als Facebook, TikTok en YouTube zeggen dat ze inhoud modereren om een veilige omgeving te bieden en hun gebruikerservaring positief te houden, hebben gebruikers soms het gevoel dat censuur hun stem beperkt.

Inhoudsmoderatie op sociale media kan soms aanvoelen als ongerechtvaardigde of onverklaarbare censuur of verbanning. Laten we eens uit de doeken doen hoe moderatie van inhoud op sociale media werkt, een paar voorbeelden uit de praktijk delen en bespreken wat u moet doen als u ermee te maken krijgt.

Waarom inhoudsmoderatie plaatsvindt op sociale media

Als u vindt dat u ten onrechte bent gecensureerd of verbannen op sociale media, zijn hier een paar veelvoorkomende redenen waarom inhoud kan worden gemarkeerd of verwijderd:

• Rapporten van gebruikers: Als genoeg gebruikers een bericht melden, wordt het gemarkeerd voor beoordeling.

• Communitynormen: Elk platform heeft zijn eigen regels die bepalen wat acceptabel is.

• Wettelijke naleving: Platforms moeten zich aan de nationale wetgeving houden, dus inhoud die op de ene plaats prima is, kan op een andere plaats worden beperkt.

Praktijkvoorbeelden van censuur op sociale media

Hier zijn enkele voorbeelden waar gebruikers vonden dat moderatie te ver ging en inhoud werd gecensureerd of verboden:

1. Politieke inhoud: Berichten over protesten of politieke bewegingen zijn verwijderd vanwege vermeende risico’s of conflicten met het beleid.

2. Neutrale rapportage: In sommige gevallen zijn verslagen van journalisten op sociale media verwijderd, alleen omdat ze terroristische organisaties noemden.

3. Artistiek naakt: Kunst, vooral als het naakt bevat, kan worden gemarkeerd op platforms met een beleid rond inhoud voor volwassenen.

Wat u moet doen als u wordt getroffen

Lees de volgende snelle tips als u merkt dat uw inhoud wordt verwijderd en denkt dat u gecensureerd bent:

1. In beroep gaan: Bij de meeste platforms kunt u in beroep gaan. Neem de tijd om uit te leggen waarom u vindt dat het bericht niet in strijd was met hun richtlijnen.

2. Communityrichtlijnen lezen: Als u de regels van het platform kent, kunt u begrijpen wat er is gebeurd en toekomstige problemen voorkomen.

3. Alternatieven overwegen: Voor gebruikers die meer controle willen over hun inhoud, kunnen andere platformen een ander moderatiebeleid bieden.

Conclusie

Hoewel moderatie van inhoud op sociale media kan aanvoelen als censuur, kan kennis van de regels u helpen om met vertrouwen door de platforms te navigeren. Sociale media zijn altijd in ontwikkeling en als u zich bewust bent van de grenzen, kunt u op een verantwoorde manier inhoud delen op verschillende platforms.

Inhoud markeren

Socialemediaplatforms bieden tools waarmee gebruikers mogelijk schadelijke inhoud kunnen markeren als onderdeel van hun inspanningen om een veilige en uitnodigende omgeving te behouden.

Met deze tools kunnen gebruikers inhoud melden die ze beledigend, schadelijk of in strijd met de richtlijnen van de community vinden, zoals haatdragende taal, expliciet materiaal, desinformatie of pesterijen.

Eenmaal gemarkeerde inhoud ondergaat meestal een beoordelingsproces, waarbij vaak geautomatiseerde systemen en menselijke moderators betrokken zijn, om te beoordelen of de inhoud moet worden verwijderd of beperkt. Tools voor het markeren helpen platforms niet alleen om sneller te reageren op ‘problematische inhoud’, maar bevorderen ook een gevoel van verantwoordelijkheid in de community, omdat gebruikers een actieve rol spelen bij het vormgeven van een veiligere onlineruimte.

Bronnen

https://transparency.meta.com/policies/community-standards/

https://www.youtube.com/intl/ALL_ie/howyoutubeworks/policies/community-guidelines/

https://www.tiktok.com/safety/en

https://support.google.com/youtube/answer/7554338?hl=en-GB